在数字和非数字表面上使用手绘图案/文本进行音乐合成的方法和系统与流程

2021-01-28 12:01:05|

2021-01-28 12:01:05| 266|

266| 起点商标网

起点商标网

[0001]

本公开涉及一种用于创建和合成音乐的方法和系统。

背景技术:

[0002]

在当前的技术时代,我们在现实生活中正在与许多音乐装置进行交互,或者基于不同的交互形式(诸如基于手势的交互、基于语音的交互、基于触摸的交互、基于点击的交互、基于视网膜的交互等)使用虚拟/增强现实以及许多有用装置或传感器与许多音乐装置进行交互。音乐的数字化已经从根本上改变了工业的各个方面,从录制音乐的方式到发行和销售唱片集的方式。

[0003]

目前使用的包括移动装置、智能电话、平板电脑、计算机、个人计算机、膝上型电脑等的电子装置能够使用各种应用执行各种功能。这些装置的一些有用的应用包括娱乐、休闲和学习。不同风格或类型的音乐可强调、削弱或省略这些元素中的一些元素。音乐是用各种乐器和从歌唱到说唱的声乐技术演奏的。此外,存在单独的乐器乐曲、单独的声乐乐曲(诸如没有乐器伴奏的歌曲)以及组合了歌唱和乐器的乐曲。

[0004]“声音合成”的定义包括对声音的元素进行组合以制造期望的声音。声音合成可使用现有的声音作为元素或电子地或机械地创建新声音。合成世界是复杂的世界,并且它将最早的电子乐器之一泰勒明电子琴(theremin)在范围和方法方面以指数方式扩展到合成器和采样器。音频合成的主要助推是数字技术在声音中的应用。结果是,合成范围在短时期内增加了许多倍。应用于合成的数字技术已经导致形成全新的学科,诸如用于多媒体(例如,最大信号处理(max/msp)、纯数据、抖动等)的依赖于计算机代码来产生声音的可视化编程语言。数字技术使得将电子设备的音调和数千小时的工作压缩到可在几秒钟内进行相同工作的便携式个人计算机中成为可能。

[0005]

乐器可根据通常的用途进行分类(诸如信号乐器),类别可包括不同霍恩博斯特尔-萨克斯乐器分类法中的乐器,诸如小号、鼓和锣。在整个历史中,已经使用了各种乐器分类方法,如欧洲文化根据管弦乐乐器家族对乐器进行分类。最常用的系统将乐器分为电子琴乐器、弦乐器、木管乐器、铜管乐器和打击乐器,然而,已经设计了其它方案。

[0006]

按照这样,存在许多允许用户创建、创作和控制音乐的输入装置。这样的技术状况与手势、传感器、应用和启用触摸屏的输入装置或基于点击的输入装置等的组合一起起作用。现有的技术状况允许用户使用一些启用传感器的手套通过手势创建和控制音乐。用户可通过将任何坚固表面(例如玻璃、木材、任何板、墙壁等)上的指尖和手掌扩展到乐器中来使用启用传感器的手套。现有的技术状况允许用户在不同平台上使用一些基于音乐的应用通过触摸屏事件来创建音乐。用户可通过将启用触摸的输入装置上的指尖或手指扩展来使用启用传感器的手套。

[0007]

目前,用户不可能具有多个按需乐器。用户不能够具有允许在数字和非数字平台上绘制和播放使其更具交互性和沉浸性的特征。此外,用户不能定制乐器,例如,绘制乐器

的完整部件/部分部件,以文本/符号形式绘制音符以根据用户的位置、参数和朝向生成合成的声音效果。此外,在乐器中的运行时间修改或任何用户需求的定制是不可用的。用户甚至不可能将背景声音对象添加到合成音乐。因此,需要创建一种克服上述缺点的系统和方法。

[0008]

以上信息作为背景信息被呈现仅用于帮助理解本公开。至于以上信息中的任何信息是否可应用为针对本公开的现有技术,尚未做出确定并且尚未进行声明。

技术实现要素:

[0009]

技术问题

[0010]

本公开的各方面在于至少解决上述问题和/或缺点,并且至少提供下面描述的优点。因此,本公开的一方面在于提供一种识别图案并将识别图案映射到乐器的系统和方法。

[0011]

本公开的另一方面在于提供一种创建和合成音乐的系统和方法。

[0012]

本公开的另一方面在于提供一种实时解锁乐器的八度音阶的系统和方法。

[0013]

本公开的另一方面在于提供一种将音乐参数与乐器映射的系统和方法。

[0014]

本公开的另一方面在于提供一种使用乐器生成透视声音和附加背景音乐的系统和方法。

[0015]

本公开的另一方面在于提供一种对乐器进行多路复用的系统和方法。

[0016]

本公开的另一方面在于提供一种与文本和符号交互的系统和方法。

[0017]

附加的方面将在下面的描述中被部分地阐述,并且部分地,将从描述而清楚,或者可通过本公开的实施例的实践来获知。

[0018]

技术方案

[0019]

根据本公开的一方面,提供了一种创建和合成音乐的方法。所述方法包括:从现有数据库、表面、相机中的至少一个获取至少一个图像,从获取的所述图像检测乐器、乐器的一部分、用户定义的交互边界和/或背景信息中的至少一个,基于所述检测识别音乐参数或背景声音参数中的至少一个,将所述音乐参数映射到来自获取的所述图像的检测到的乐器、乐器的一部分、用户定义的交互边界和/或背景信息中的至少一个,实时解锁检测到的至少一个乐器的八度音阶,接收所述至少一个乐器的位置、朝向、相对位置、深度和/或尺寸,接收基于获取的所述图像的至少一个交互输入,并且基于接收到的所述交互输入、所述至少一个乐器的相对位置、朝向或尺寸中的至少一个生成透视声音。

[0020]

根据本公开的一方面,音乐基于交互输入或背景声音参数中的至少一个被合成。

[0021]

根据本公开的另一方面,多个乐器被检测并且还被联结到检测到的所述至少一个乐器。

[0022]

根据本公开的另一方面,至少一个乐器的声音是根据另一乐器生成的。

[0023]

根据本公开的另一方面,透视声音基于用户与所述乐器的相对位置和/或识别出的对象与所述乐器的相对位置中的至少一个被生成。

[0024]

根据本公开的另一方面,虚拟现实(vr)装置能够检测用户与乐器的相对位置。

[0025]

根据本公开的另一方面,获取的图像包括手绘图像、打印图像、图像模板或文本中的至少一个。

[0026]

根据本公开的另一方面,多个用户基于多个表面被识别并被映射到所述乐器。

[0027]

根据本公开的另一方面,音乐由多个用户基于接收到的所述交互输入、所述乐器的相对位置、朝向或尺寸中的至少一个被生成和被合成。

[0028]

根据本公开的另一方面,获取的图像由电子装置上的至少一个传感器捕获。

[0029]

根据本公开的另一方面,传感器是光学传感器、图像传感器、红外传感器和/或电子输入传感器中的至少一种。

[0030]

根据本公开的另一方面,表面是电子表面或非电子表面中的至少一种。

[0031]

根据本公开的另一方面,电子表面生成电子格式的图像文件,并且非电子表面生成非电子格式的图像文件。

[0032]

根据本公开的另一方面,检测和识别在云服务器、本地服务器或用户电子装置中的至少一个上被执行。

[0033]

根据本公开的另一方面,音乐参数包括八度音阶、音符、音符组成和音阶中的至少一个。

[0034]

根据本公开的另一方面,所述音乐参数被配置为基于所述用户交互输入生成声音。

[0035]

根据本公开的另一方面,所述用户交互输入包括所述至少一个乐器的书写音符或文本中的至少一个。

[0036]

根据本公开的另一方面,交互输入通过手势、触摸、语音或手写笔中的至少一个被生成。

[0037]

根据本公开的另一方面,合成操作包括以下项中的至少一项:基于手绘图像上的交互输入以及映射信息生成音符;合并通过手绘图像集合上的交互输入集合生成的音符集合,对通过至少一个手绘图像上的至少一个交互输入生成的至少一个音符和背景声音参数进行合并。

[0038]

根据本公开的另一方面,方法还包括:接收手绘图像上的至少一个附加的交互输入,并且基于附加的交互输入、背景声音参数来合成音乐。

[0039]

根据本公开的另一方面,方法还包括:更新手绘图像或图像模板中的至少一个,基于更新的手绘图像或图像模板中的至少一个来合成音乐。

[0040]

根据本公开的另一方面,方法还包括基于音乐合成来创作音乐文件。

[0041]

根据本公开的实施例,一种系统包括:用户装置,从现有数据库、表面、相机、服务器中的至少一个获取至少一个图像;服务器,从获取的图像检测乐器、乐器的一部分、用户定义的交互边界和/或背景信息中的至少一个;对象映射模块,将至少一个音乐参数映射到来自手绘图像的检测到的乐器、乐器的一部分、用户定义的交互边界和/或背景信息中的至少一个;八度音阶解锁模块,实时解锁检测到的至少一个乐器的八度音阶;传感器模块,使用传感器单元接收至少一个乐器的位置、朝向、相对位置、深度和/或尺寸;音频模块,接收基于获取的所述图像的至少一个交互输入;生成模块,基于接收到的所述交互输入、所述至少一个乐器的相对位置、朝向或尺寸中的至少一个生成透视声音;以及运动检测模块,从手绘图像检测至少一个交互输入。

[0042]

根据本公开的实施例,系统还包括:处理模块,基于交互输入合成音乐。

[0043]

根据本公开的另一实施例,系统还包括:检测多个乐器并将检测到的所述至少一个乐器联结到所述多个乐器。

[0044]

根据本公开的另一实施例,至少一个乐器的声音是根据另一乐器生成的。

[0045]

根据本公开的另一实施例,其中,透视声音基于用户与乐器的相对位置和/或识别出的对象与乐器的相对位置中的至少一个被生成。

[0046]

根据本公开的另一实施例,虚拟现实(vr)装置能够检测用户与乐器的相对位置。

[0047]

根据本公开的另一实施例,获取的图像包括手绘图像、打印图像、模板图像、数字表面图案、数字格式图像或文本中的至少一个。

[0048]

根据本公开的另一实施例,多个用户基于多个表面被识别并被映射到所述乐器。

[0049]

根据本公开的另一实施例,音乐由多个用户基于接收到的所述交互输入、所述乐器的相对位置、朝向或尺寸中的至少一个被生成和被合成。

[0050]

根据本公开的另一实施例,手绘图像由电子装置上的至少一个传感器捕获。

[0051]

根据本公开的另一实施例,传感器是光学传感器、图像传感器、红外传感器和/或电子输入传感器中的至少一种。

[0052]

根据本公开的另一实施例,表面是电子表面或非电子表面中的至少一种。

[0053]

根据本公开的另一实施例,电子表面生成电子格式的图像文件,并且非电子表面生成非电子格式的图像文件。

[0054]

根据本公开的另一实施例,检测和识别在云服务器、本地服务器和/或用户电子装置中的至少一个上被执行。

[0055]

根据本公开的另一实施例,音乐参数包括八度音阶、音符、音符组成和音阶中的至少一个。

[0056]

根据本公开的另一实施例,所述音乐参数被配置为基于所述用户交互输入生成声音。

[0057]

根据本公开的另一实施例,所述用户交互输入包括所述至少一个乐器的书写音符或文本中的至少一个。

[0058]

根据本公开的另一实施例,交互输入通过手势、触摸、语音和/或手写笔中的至少一个被生成。

[0059]

根据本公开的另一实施例,处理模块包括以下项中的至少一项:生成装置,基于手绘图像的所述交互输入和所述映射来生成至少一个音符;合并装置,至少合并通过手绘图像集合的交互输入集合生成的音符集合,并且还将通过至少一个手绘图像的至少一个交互输入生成的至少一个音符和背景声音参数进行合并。

[0060]

根据本公开的另一实施例,系统还包括:接收装置,接收手绘图像的至少一个附加的交互输入;以及处理模块,基于附加的交互输入和/或背景声音参数中的至少一个来合成音乐。

[0061]

根据本公开的另一实施例,系统还包括:更新装置,更新手绘图像或图像模板中的至少一个;以及处理模块,基于更新的手绘图像或图像模板中的至少一个来合成音乐。

[0062]

根据本公开的另一实施例,系统还包括:编写装置,基于音乐合成来创作音乐文件。

[0063]

根据以下结合附图公开了本公开的各种实施例的详细描述,本公开的其它方面、优点和显著特征对于本领域技术人员将变得显而易见。

附图说明

[0064]

通过以下结合附图进行的描述,本公开的特定实施例的以上和其它方面、特征和优点将更加明显,其中:

[0065]

图1a示出根据本公开的实施例的系统概述。

[0066]

图1b示出根据本公开的实施例的服务器的架构。

[0067]

图2示出根据本公开的实施例的对象多路复用架构。

[0068]

图3是示出根据本公开的实施例的音乐的创建和合成的流程图。

[0069]

图4示出根据本公开的实施例的用于检测表面上的任何对象的数字装置的系统架构。

[0070]

图5a示出根据本公开的实施例的绘制图案到预定义对象的映射。

[0071]

图5b示出根据本公开的实施例的八度音阶的解锁。

[0072]

图5c示出根据本公开的实施例的用户与多个乐器交互。

[0073]

图5d示出根据本公开的实施例的多个乐器的映射。

[0074]

图5e示出根据本公开的实施例的多个乐器的八度音阶映射。

[0075]

图5f示出根据本公开的实施例的乐器的音符到形状的映射。

[0076]

图5g示出根据本公开的实施例的乐器的音符到加载的形状的映射。

[0077]

图6a示出根据本公开的实施例的基于透视的声音生成。

[0078]

图6b示出根据本公开的实施例的基于乐器的尺寸和位置的透视声音生成的示例。

[0079]

图6c示出根据本公开的实施例的多个对象到服务器上的预定义对象的映射。

[0080]

图6d示出根据本公开的实施例的基于用户位置的透视声音生成。

[0081]

图7a示出根据本公开的实施例的基于用户相对位置的透视声音生成。

[0082]

图7b示出根据本公开的实施例的基于用户的相对位置的透视声音生成的示例。

[0083]

图7c示出根据本公开的实施例的基于用户的头部与头戴式装置的相对位置的透视声音生成的示例。

[0084]

图8a示出根据本公开的实施例的乐器的打印图像到预定义乐器的映射。

[0085]

图8b示出根据本公开的实施例的用户与乐器的打印模板交互。

[0086]

图9a示出根据本公开的实施例的乐器的打印图像的映射。

[0087]

图9b示出根据本公开的实施例的在装置上的多个乐器的映射。

[0088]

图10a示出根据本公开的实施例的用户与虚拟助理(va)交互以映射乐器。

[0089]

图10b示出根据本公开的实施例的用户与虚拟助理交互以映射另一乐器。

[0090]

图10c示出根据本公开的实施例的用户对映射在装置上的多个乐器进行定位和缩放/调整尺寸。

[0091]

图10d示出根据本公开的实施例的用户与虚拟助理交互以映射另一对象。

[0092]

图10e示出根据本公开的实施例的用户重新定位三个映射的乐器并与三个映射的乐器交互以及与它们交互。

[0093]

在整个附图中,相同的参考标号将被理解为指相同的部件、组件和结构。

具体实施方式

[0094]

提供以下参照附图的描述以帮助全面理解本公开的各种实施例,提供以下参照附

图的描述以帮助全面理解由权利要求及其等同物限定的本公开的各种实施例。它包括各种具体细节以帮助理解,但这些具体细节仅被认为是示例性的。因此,本领域普通技术人员将认识到,在不脱离本公开的范围和精神的情况下,可对本文描述的各种实施例进行各种改变和修改。此外,为了清楚和简明,可省略对众所周知的功能和结构的描述。

[0095]

在以下描述和权利要求书中使用的术语和词语不限于书目含义,而是仅被发明人使用以使得能够清楚且一致地理解本公开。因此,对于本领域技术人员应显而易见的是,提供本公开的各种实施例的以下描述仅用于说明目的,而不是用于限制由所附权利要求及其等同物限定的本公开的目的。

[0096]

将理解,除非上下文另有明确指示,否则单数形式包括复数指示物。因此,例如,提及“组件表面”包括提及一个或更多个这样的表面。

[0097]

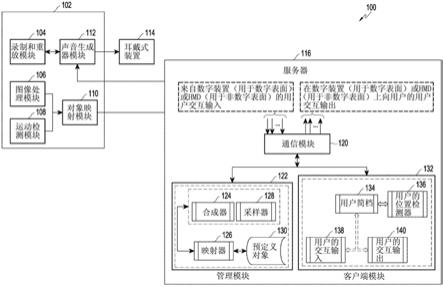

图1a示出根据本公开的实施例的系统概述。

[0098]

参照图1,系统100包括处理以下操作的各种模块:诸如运动检测和手势识别、绘制图像识别、识别出的图像映射在真实乐器上、手指/手部运动检测和相应的映射声音乐器音符生成以及各种组件的通信的。系统能够扫描从相机模块拍摄或在用户装置102的数字表面上绘制的图像。用户装置102对图像进行预处理以隔离噪声水平,并从图像中提取对象。误差被减小并且图像的精度被增强,以准确地映射乐器或物理对象。图像还被发送到对象检测模块以被进一步与服务器116共享,以用于对象识别和映射。识别出的对象可以是预定义对象(诸如钢琴键、吉他弦、打击乐器、风景、诸如河流、风、啁啾鸟等的真实对象)中的一个对象。

[0099]

运动检测模块108检测手或手臂运动以检测用户当前正在绘制的图案的种类。它检测当用户绘制或演奏绘制的乐器时手臂、手和手指的连续运动。被动红外(pir)运动检测器检测由人体部位发射的红外能量并识别能量水平的改变,其中,所述能量水平的变化最终转换为运动检测和图案识别。pir运动检测器将由用户绘制的对象的预处理图像发送到服务器116。在与对象成功匹配时,对象映射模块110接收对象信息以及可属于特定八度音阶或整个乐器音符的相应的音乐文件。如果用户装置102没有对映射的乐器和对象进行本地存储,则对象映射模块110还可基于运动检测模块108或图像处理模块106的触发来请求服务器116发送相应的声音数据。也就是说,对象映射模块110与用于产生绘制图案的实时声音的声音生成模块通信。

[0100]

服务器116被直接连接到同时处理单个/多个客户端请求的通信模块120。通信模块120处理从用户接收的用于对象识别、对象映射等的输入。通信模块120能够与服务器116的内部组件以及客户端模块132交互。通信模块120与管理模块122和客户端模块132交互。

[0101]

客户端模块132处理用户的集中服务并认证用户;客户端模块132还检测用户位置/朝向改变中的任何改变,处理用户交互输入138并生成输出140。客户端模块132维护用户简档134,检测用户的物理位置和朝向,接收用户交互输入138并生成输出140。

[0102]

管理模块122具有播放和录制生成的音乐的采样器128,它还负责对从用户(单个/多个)接收到的请求进行采样和合成。映射器模块126执行对象识别并将它们映射到预定义对象130。映射器模块126还负责向合成器124提供透视声音输入,并将位置和尺寸序列参数分配给识别出的对象。此外,存储介质存储针对每个用户生成的音乐。

[0103]

声音生成器模块112基于从对象映射模块110接收到的输入实时工作,并且基于从

服务器116实时接收识别出的对象声音数据来触发声音的生成。从对象映射模块110发送的任何运动变化或新绘制的图案促使服务器116发送可实时播放的相应的声音文件。因此,用户的移动手指或手势将基于声音生成器模块112实时生成声音。产生的声音将继续添加到已经产生的声音,并且将创建可由录制和重放模块104录制和重放的音乐。生成的声音被发送到耳戴式装置114,其中,生成的声音被用户听到。此外,录制和重放模块104在通过对象映射模块110从声音生成器模块112接收到识别出的对象声音数据时,录制声音并存储声音。录制的文件可在之后被删除、修改或播放。

[0104]

图1b示出根据本公开的实施例的服务器的架构。

[0105]

参照图1b,示出服务器116的框图150,并且服务器116提供可存储、操纵和访问信息的集中式装置。服务器116从用户侧接收连续数据,并且所述请求可以是两种类型,具有用于图案识别和对象识别的绘制图案图像的请求,其中,绘制图案最终成为具有诸如音乐文件、乐器类型等的属性的一个对象。另一请求可以是当用户用更多的八度音阶或更多的对象扩展绘制图案而因此对于每个对象,服务器116将相应的映射乐器音符集发送给用户的时候。存在处理单用户场景和多用户场景的通信模块120。通过在服务器116上为想要与房间中的其它用户一起演奏乐器的所有用户创建房间来处理多用户场景。

[0106]

通信模块同时处理单用户请求/多用户请求。通信模块从客户端接收用于对象识别和映射的输入。该模块与服务器116的内部组件交互,并且还与外部的客户端交互。该模块是用户与服务器116交互的主接口。通信模块120提供系统的用户(管理客户端和用户客户端两者)与服务器116之间的通信服务。该模块表示驻留在服务器116上的通信链路的一部分。

[0107]

客户端模块132处理与用户相关的集中式服务,并且能够认证用户,检测任何用户位置/朝向改变,并处理连续的用户交互输入138并生成输出140。在客户端模块132处维护每个用户的用户简档134以用于访问认证、会话处理、频繁请求处理等,并且针对历史记录维护用户数据库。用户位置检测器为每个用户登记用户的物理位置或朝向,并且参数的任何改变立即被馈送到合成模块以用于包括在合成音乐输出中的透视改变。由于参数没有改变,因此没有改变被馈送到透视声音生成。用户交互输入138与客户端装置上的绘制图案交互,并且用其输入连续地更新服务器116。对于来自客户端装置的每个输入,生成相应的声音,并且将针对新八度音阶输入发生八度音阶解锁。用户交互输出140用于用户交互,并且导致声音文件被服务器116解锁并被服务器116与客户端装置共享。此外,根据基于透视的位置/尺寸参数的合成输出被与用户共享。因此,用户总是在用户的声音输出介质上收听基于透视的声音。

[0108]

根据本公开的实施例,服务器116还包括还包含采样器128的管理装置122,以在多用户环境中播放和录制由采样器128模块生成的音乐。由于每个连接到房间的用户必须收听通过他们各自的乐器/对象的融合生成的同一声音,因此采样器128可播放、录制将与连接的客户端中的每一个客户端同时共享的轨道。该模块有助于对多客户端请求场景进行采样或合成,其中,在多客户端请求场景中,每个客户端同时演奏映射在服务器116上的乐器。用户创建的音乐被采样或被合成以形成融合的音乐轨道,就像正在演奏的管弦乐团一样,并且还处理多用户场景中的音乐生成。包含正在由被访问的房间的每个成员演奏的多个乐器的房间被融合在一起以创建融合的音乐。访问该房间的用户通过通信模块120在他们各

自的装置上收听由采样器128创建的融合音乐。

[0109]

根据本公开的实施例,映射器模块126通过图案匹配来执行对象识别。在从客户端接收到图案时,映射器模块126尝试将接收到的对象图案与预定义对象的图案进行匹配。由于在由服务器116接收的预处理图像中可能存在多个对象,因此映射器模块126识别对象的数量。在服务器116侧,在每个接收到的对象与预定义图案成功匹配时,服务器116识别乐器或对象并将相应的音乐文件发送给用户。用户还可绘制图案,其中,对于该图案,映射器模块126识别它是已经绘制的图案的扩展还是新对象的新图案。因此,或者发生八度音阶解锁,或者与客户端共享新对象音乐。映射器还负责到合成器124的透视声音输入,这是因为它处理输入图像并识别每个对象,并且还将位置和尺寸序列参数分配给每个识别出的对象。此外,尺寸序列以识别出的对象的相对尺寸的降序示出所述对象的顺序。因此,当进行绘制并绘制各个对象时,对它们的尺寸进行相对地比较,并将序列号分配给每个对象。因此,与序列号为2的对象相比,序列号1将在合成音乐轨道中具有突出的声音,其中,按照次序,序列号为2的对象将比此后具有更大序列号的对象具有更多突出性。分配的序列顺序随着添加到绘图的更多对象以及它们与绘图区域上绘制的其它对象的相对比较而不断改变。位置序列相对于x-y轴上的中心参考点映射识别出的对象。因此,当进行绘制并绘制各个对象时,对它们的相对位置进行相对比较并计算中心参考点,其中,该中心参考点反过来决定每个对象相对于x-y轴上的中心位置的相对位置。因此,将相对值分配给将在合成音乐轨道中具有基于透视的定向声音的每个对象。因此,与位置序列为0的对象相比,在位置序列4处绘制的对象将具有来自声音输出装置的右声道的更突出的输出,并且来自位置序列为-4的对象最终在左声道上具有突出声音,其中,位置序列为0的对象将在左声道和右声道两者处具有均等的输出。分配的序列顺序随着添加到绘图的更多对象以及它们与绘图区域上绘制的其它对象的相对比较而不断改变。位置序列相对于捕获的帧的中心处的参考点以及每个识别出的对象相对于参考点的相对位置被分配。存储模块存储生成的与每个用户相应的音乐,并且还存储每个用户的简档数据以用于将来的高速缓存。对于多用户,它存储来自每个客户端的采样音乐。

[0110]

在本公开的实施例中,表面上的用户绘制图案将由中间对象识别器装置检测,其中,中间对象识别器装置可包括具有相机传感器的头戴式装置、具有运动检测的腕戴式装置、相机、笔等。然后,绘制的图像按照绘制的图案与预定义乐器集合或特定对象声音(诸如流动河流、啁啾鸟或背景配乐)中的一个映射。这些所有声音被实时生成。因此,用户将在绘制和收听映射的生成声音的同时提供真实生活体验。用户还可删除或替换绘图以去除生成的声音。具有所有预定义对象及其相应声音的服务器(116)将与用户的装置实时通信。因此,乐器被映射到中间八度音阶,并且如果用户想要从较低音符生成声音,则他必须绘制乐器的较低部分。当用户绘制右侧八度音阶时,右侧八度音阶将被映射在服务器116上。由用户按下和弹奏的键将在后台被映射到服务器116侧的实际尺寸乐器的键或弦中的一个。收听来自服务器116的声音的用户将通过相应地按压来调整他的手指,并且将相应地校准音符。绘图的任何进一步扩展应包括乐器的其它八度音阶/键/弦。

[0111]

图2示出根据本公开的实施例的对象多路复用架构。

[0112]

参照图2,示出了对象多路复用架构200,其中,给予乐器的每个输入与单个乐器/多个乐器同时映射。例如,如果用户已经绘制了被识别为钢琴、长笛和鼓的3种乐器,并且所

有乐器都处于启用状态,则与钢琴的单个交互应同时导致由长笛和鼓生成的输出。此外,如果钢琴被禁用,则启用的乐器(诸如鼓和长笛)的声音将基于给予钢琴的输入音符被生成。乐器的每个输入与所有乐器的八度音阶键一对一映射。在音符映射器模块204中,乐器的每个输入基于乐器的当前模式与一个或更多个乐器映射。因此,单个输入可生成来自于所有针对输入键音符正在被演奏的多个乐器的输出。输入映射器将输入音符发送到每个启用的乐器,与此相应,每个乐器的乐器键音符信息被发送到声音混合器210。

[0113]

声音混合器210基于每个乐器的输入键生成音符声音。与输入映射的每个声音被由声音混合器210混合以生成单轨道音乐。合成器124融合每个乐器的声音键音符并生成在客户端的输出装置处播放的单个音乐轨道。

[0114]

图3是示出根据本公开的实施例的音乐的创建和合成的流程图。

[0115]

参照图3,流程图300示出说明装置的操作的各种处理。处理1包括在操作304绘制图像、捕获打印图像等。根据用户的偏好,预定义对象被联结到打印图像或手绘图案。处理2包括对象识别、对象位置识别模块306和对象映射模块308,其中,处理2涉及通过对象位置识别模块306将触发310与预处理图像一起发送到服务器116。对于对象识别,服务器116通过图案识别来识别接收到的图像中的各个对象。在成功匹配时,服务器116向客户端发回识别出的对象及其所有属性信息。对象位置识别模块306识别每个对象的相对位置并且进行映射以用于透视声音生成。对象映射模块308根据输入识别被映射到唯一实体(例如,乐器、动物、鸟或诸如河流的物理对象)的对象。

[0116]

根据本公开的实施例,进一步的处理包括处理3,其中,处理3包括用户交互和基于用户交互输入138的声音生成、以及根据启用的乐器上的交互输入的声音生成。声音生成还涉及用于输入交互312和乐器映射314的处理3a,即,在手绘图案或打印对象的成功识别和映射之后,输入与单个或多个乐器映射。基于乐器的当前状态(即,启用/禁用)和当前交互对象,每个输入键可与单个或更多个乐器映射,并且处理3b包括被发送到服务器116以用于声音生成的多路复用输入(被发送到服务器116以用于混合的交互输出332)。

[0117]

根据本公开的另一实施例,处理4示出服务器116接收交互输入和用户位置输入,将音乐与所有输入的乐器/对象声音合成,并将合成的音乐输出到用户装置(例如,扬声器或耳机206)。此外,处理5示出包括用户相对位置更新和映射信息的用户相对位置检测。用户相对位置更新基于用户的头部移动和绘制对象的相对位置来识别从用户到服务器116的透视输入。此外,用户相对位置更新和映射信息在检测到用户位置的任何改变时更新用户位置,并且合成基于透视的音乐声音并发送回用户。

[0118]

图4示出根据本公开的实施例的用于检测表面上的任何对象的数字装置的系统架构。

[0119]

参照图4,装置的框图400包括:用于运行系统指令的处理器412;用于存储可运行应用、api、中间件和内核的存储器414;用于管理正在运行的应用的应用控制模块;用于与用户交互的输入/输出接口;用于与其它装置(配对的或连接的装置)或远程服务器通信的通信模块402;用于显示可视信息的显示模块406;用于与其它装置连接的接口408;用于接收根据通过麦克风给出的命令的输入并处理该输入以识别对象绘制请求的虚拟助理(va)模块426。在装置中,在传感器模块410中存在多个传感器,其中,在检测到诸如触摸、运动检测、手势识别等的各种输入时,传感器模块410将触发发送到装置。电源模块430保持检查电

源管理。相机模块422甚至在来自传感器的触发下捕获图像。如果需要,接口模块将装置与其它输入配对。

[0120]

根据本公开的实施例,通信模块402是用户装置与远程服务器之间的接口。用户装置与服务器116实时通信。针对在用户侧由传感器模块410发送的每个触发,通信模块402将预处理的图像数据和用户的位置数据发送到服务器116,用于图案识别、对象映射和透视声音合成。在成功映射时,通信模块402从服务器116接收存储在存储器414中的声音数据。针对由输入装置404接收的任何输入,如果输入完全在映射对象的已经解锁的部分内,则它使用存储在存储器414中并且不需要与服务器116连接的音乐数据,或者它与服务器116通信以发送用户装置当前不可用的其它音乐数据。所使用的各种通信手段包括wi-fi、蜂窝等。

[0121]

传感器模块410从诸如陀螺仪传感器、加速度传感器等的各种源接收装置位置和朝向。装置位置取决于用户的头部位置,并且因此随着用户的头部移动,装置的位置参数也改变。因此,位置参数在被改变时在服务器116端被更新。服务器116基于位置参数将输出声音与添加到乐器的声音的用户透视参数合成。例如,人正在弹钢琴,并且在钢琴的右侧绘制吉他。因此,基于位置,应同样地从扬声器或耳机206听到透视声音。当人朝向右侧移动他的头部时,透视声音使得吉他的声音比钢琴的声音更突出。

[0122]

连接到扬声器416、受话器418和麦克风420的音频模块422基于在表面上绘制的映射对象中的每个对象的相对位置和尺寸从服务器116接收透视声音,其中,映射对象用其各自的音频流标记。因此,当输出音频流被馈送到扬声器或耳机206的不同声道以产生环绕声效果时,生成透视声音。例如,考虑在钢琴的左侧绘制小号,并且在钢琴的右侧绘制吉他。应同样地从扬声器或耳机206听到声音。现在,考虑到绘制的吉他小于钢琴,将被认为是相对更远的声音,并且在扬声器416上的输出中将更突出地听到绘制得比钢琴的尺寸大的吉他。

[0123]

在本公开的实施例中,相机模块422捕获装置前面的图像,其中,所述图像包括手绘图案或预定义模板。对象映射模块110基于每个映射对象的相对位置和尺寸来接收输入参数。因此,每个对象的相对位置及其位置参数有助于增加透视声音生成。

[0124]

va模块426根据通过麦克风420给出的命令接收输入,并处理该输入以识别对象绘制请求。基于用户给出的命令,va以乐器或任何背景对象的形式在屏幕上绘制对象。用户还在多个乐器场景中给出关于框架内的绘制对象相对于其它对象的位置的输入。用户还可给出停止绘制的命令,并且能够随时与部分绘制的对象交互。

[0125]

根据本公开的另一实施例,存储器414存储预处理的图像数据,直到预处理的图像数据被服务器116识别并与对象映射。映射的对象连同其相应的音乐文件一起存储在存储器414中,并且如果存储的数据存在于本地存储器中,则可直接访问对存储的数据的任何将来参考。可选地,参考服务器116。如果用户的位置数据和对象相对位置数据没有改变,则直接从存储的数据参考透视声音。服务器116在检测到任何对象的相对尺寸或位置改变或者用户的位置/朝向改变时触发更新的音乐数据。对对象的每个输入与单个对象或多个对象映射,因此映射数据也被存储在存储器414中。合成的音乐在装置上被播放,并且还可在被录制时被存储,并且此后可被重放。

[0126]

在实施例中,与音乐采样器元件相关的操作包括手的运动的检测,其中,手的运动的检测还包括用户佩戴配备有运动传感器的装置,并且由该装置检测用户前方的任何运动。接近传感器和运动传感器能够共同检测装置前方的运动。此外,该元件包括对用手绘制

的对象的检测,其中,如果绘制是在纸或任何其它非数字表面上完成的,则运动检测信号被发送到相机模块422以对在表面上绘制的任何对象进行拍摄和预处理。图案识别发生在服务器116侧。因此,相机仅将预处理的图像发送到服务器116以进行对象检测和映射。检测到的对象可以是乐器或用于氛围创建的背景环境。生成的环境声音的属性应基于绘图中的对象的位置,例如,与更远的对象相比,更近的对象将在声音中是突出的。左侧的对象在扬声器或耳机206的左手侧将更容易听得见,并且对于右侧对象也是如此。在数字表面上绘制的图具有存储在装置中的预定义图案。因此,图案的图像可被直接与服务器116共享。

[0127]

此外,绘制图案与预定义乐器中的一个的映射包括服务器116从用户接收图像。图像包括对象的手绘图案。服务器116用其预定义对象数据库检查它是否与对象之一匹配,并且完成对象识别和绘制的乐器的一部分的中间八度音阶的映射。在成功检测到乐器时,服务器116检查乐器的一部分是否被绘制,并且在该部分被绘制的情况下,服务器116发送与被绘制的乐器的中间八度音阶相应的音乐文件。为了映射整个乐器,绘制应包含所有八度音阶,并且如果检测到整个乐器被绘制,则整个音符文件被与用户共享。针对任何其它对象(诸如河流、鸟等),共享相应的音乐文件。为了在音频装置上生成映射的音符中的一个音符,与绘制的乐器相应地生成音乐,并且进一步地,在每次用户与绘制的图案交互时,连续地重复该处理。

[0128]

图5a示出绘制图案到预定义对象的映射500。用户绘制对象(优选地为乐器)的部分形状,并且当用户绘制对象的形状时,中间对象识别器装置(包括相机、智能电话、诸如启用相机的智能挂件的智能珠宝、智能笔等)将绘制形状的信息发送到服务器116,其中,服务器116能够根据预定义对象识别绘制形状。服务器116将确认发送到用户的中间对象识别器装置,其中,所述确认确认对象是否被识别。在对象(例如,吉他、钢琴、背景声音等)被识别的情况下,当服务器116将识别出的装置映射到预定义对象时,用户可与识别出的装置交互。然而,在对象未被识别的情况下,用户可继续绘制形状,同时中间对象识别器装置保持实时跟踪正被绘制的对象。

[0129]

根据本公开的实施例,一旦中间对象识别器装置识别出对象,中间对象识别器装置就开始将绘制形状的信息发送到服务器116,并且服务器116识别绘制形状并将绘制形状与预定义对象映射,并且解锁绘制的乐器的所有八度音阶。例如,如果用户绘制吉他,则服务器识别对象并将其映射到预定义对象,如吉他。用户开始与吉他交互。随后,诸如吉他的对象然后被映射到预定义对象,并且服务器116解锁乐器的所有八度音阶。用户可与乐器交互并合成来自乐器的音乐。乐器为用户提供真实生活演奏体验。

[0130]

图5b示出根据本公开的实施例的八度音阶的解锁。

[0131]

参照图5b,用户在电子表面/非电子表面或数字表面上绘制电子琴/钢琴的中间八度音阶以解锁音乐八度音阶502。用户在表面上部分地绘制几个键,并且服务器116识别绘制的对象并将其映射到预定义乐器。然后,解锁电子琴/钢琴的中间八度音阶,即(c4-c5)1gestreept。一旦映射完成,用户就与乐器交互。

[0132]

根据本公开的实施例,然后,用户绘制乐器(电子琴)的左八度音阶,即中间八度音阶c4-c5(1gestreept)的左侧八度音阶。一旦八度音阶被解锁,用户就可播放音乐并在所述乐器上创建音乐轨道。

[0133]

根据本公开的实施例,用户还绘制乐器(例如,电子琴)的右八度音阶,即,中间八

度音阶的右侧八度音阶。用户绘制右八度音阶,并且装置能够实时识别八度音阶。一旦识别出八度音阶,就将其解锁并映射到预定义乐器的右八度音阶。用户可在整个乐器被解锁的情况下创建完整的音乐轨道。

[0134]

图5c示出根据本公开的实施例的用户与多个乐器交互。

[0135]

参照图5c,当显示多个乐器504时,用户连同吉他、长笛和鼓一起绘制电子琴。使用映射器模块126将所述乐器映射到预定义对象130,如电子琴、吉他、长笛和鼓。这些乐器的八度音阶在此处理中被映射器模块126实时解锁。基于这些乐器的尺寸和位置,乐器被相应地编号为1、2、3和4(例如,基于尺寸,1:鼓,2:电子琴,3:吉他和4:长笛),映射器模块126基于映射的乐器的尺寸和位置分配尺寸序列和位置序列。一旦所有乐器都被映射并且同样地八度音阶被解锁,则用户与乐器交互,并且乐器基于它们的尺寸、定位和位置产生声音。在用户与吉他交互的情况下,他将从左上方接收声音,即,左侧的声音将更突出,而长笛将从左下方产生声音,该声音将比长笛的声音更不突出。因此,声音基于装置的透视位置,并且音量基于尺寸和位置。因此,较大的绘制对象将产生较响亮的声音,并且较小的绘制对象将产生较低的音量。

[0136]

图5d示出根据本公开的实施例的多个乐器的映射。

[0137]

参照图5d,用户映射多个乐器以创建交响乐,其中,他映射电子琴、鼓和长笛。装置基于尺寸将这些乐器标记为1、2和3,并且因此这些乐器的位置也被映射。

[0138]

根据本公开的实施例,用户知道如何演奏电子琴,但不知道如何演奏鼓和长笛。因此,他可启用对多个乐器506的所有控制,其中,多个乐器506包括电子琴上鼓和长笛。因此,电子琴将是交互对象,并且鼓和长笛将被启用。服务器116中的音符映射器模块将鼓和长笛的所有音符映射到电子琴,并根据乐器的位置在电子琴上解锁鼓和长笛的所有八度音阶。还可根据用户的意愿禁用所启用的乐器。在中间对象识别器装置的帮助下,用户可对放置的乐器输入交互。例如,用户可在中间八度音阶中输入交互以播放电子琴的声音,在左八度音阶中输入交互以生成鼓的声音,并且在右八度音阶中输入交互以生成长笛的声音。因此,基于乐器的位置和尺寸,产生透视声音,并且用户仅通过与电子琴交互就能够生成鼓和长笛两者的声音。

[0139]

图5e示出根据本公开的实施例的多个乐器的八度音阶映射。

[0140]

参照图5e,示出多个乐器508上的八度音阶映射。也就是说,当用户不知道如何演奏鼓和长笛并且仅能演奏电子琴时,用户可在电子琴上提供对鼓和长笛的所有控制。

[0141]

在本公开的实施例中,用户将“标签1对象(电子琴)”标记为“交互对象”,然后,将“标签2和标签3对象(鼓和长笛)”标记为“启用的乐器”。服务器116中的音符映射器模块204根据它们的位置在电子琴上映射鼓和长笛的所有八度音阶并解锁所有八度音阶,同样地,左侧八度音阶被解锁并被映射到鼓,右侧八度音阶被解锁并被映射到长笛,并且中间八度音阶被解锁用于电子琴。在应通过使用交互对象或乐器来生成在启用的对象中的相应音符的一个交互声音的时候,启用的乐器(鼓和长笛)具有启用/禁用模式。

[0142]

根据本公开的实施例,用户可演奏“标签1对象(电子琴)”/与“标签1对象(电子琴)”交互,并且通过与中间八度音阶交互生成“标签1对象(电子琴)”的声音,并且通过与电子琴的左侧八度音阶交互生成“标签2对象(鼓)”的声音,并且通过与电子琴的右侧八度音阶交互生成“标签3对象(长笛)”的声音。尽管用户仅与绘制在页面中心的电子琴交互,但由

于其八度音阶音符与多个乐器的音符映射,如左侧八度音阶与鼓映射,右侧八度音阶与长笛映射,并且中间八度音阶被解锁用于电子琴,因此当用户与电子琴的键交互时,应用生成鼓、电子琴和长笛的声音,并且基于鼓、电子琴和长笛的位置和尺寸,能够生成透视声音效果。鼓被绘制在页面的左侧上,因此,用户从左侧得到鼓的声音。长笛被绘制在页面的右侧,并且尺寸最小,因此相应地生成声音。电子琴被绘制在页面的中心并且尺寸更大,并且应用根据位置和尺寸生成声音。因此,用户可通过使用多个乐器创建现场交响乐。

[0143]

图5f示出根据本公开的实施例的乐器的音符到形状的映射。

[0144]

参照图5f,当用户不知道如何演奏乐器时,用户可将乐器的音符映射为形状510并且能够与之交互以演奏和学习乐器。用户可绘制吉他和形状(即,吉他的音符被加载为形状)。按照这样,用户能够触摸已经被映射到吉他音符的形状,因此,当用户触摸该形状时,输出声音是吉他的声音,使得用户能够学习和演奏吉他。

[0145]

图5g示出根据本公开的实施例的乐器的音符到加载的形状的映射。

[0146]

参照图5g,当用户不知道如何演奏电子琴时,用户可加载将被映射到电子琴音符和电子琴的形状的一些形状512,并且解锁映射的形状的八度音阶。在映射之后,用户通过触摸加载的形状开始演奏电子琴,由于加载的形状与电子琴音符映射,因此当用户触摸映射的形状时,产生电子琴声音。

[0147]

图6a示出根据本公开的实施例的基于透视的声音生成。

[0148]

参照图6a,尺寸序列以对象的相对尺寸的降序示出识别出的对象的顺序以用于基于透视的声音生成600。因此,当绘制各个对象时,对它们的尺寸进行相对地比较,并将序列号分配给每个乐器。因此,与序列号2对象相比,序列号1将在合成音乐轨道中具有突出的声音,依次地,序列号2对象将比此后具有更大序列号的乐器具有更多突出性。分配的序列顺序随着添加到绘图的更多对象以及它们与绘图区域上绘制的其它对象的相对比较而不断改变。

[0149]

根据本公开的实施例,位置序列相对于识别出的对象在x-y轴中的中心参考点映射识别出的对象。因此,当绘制各个对象时,对它们的相对位置进行相对比较,并计算中心参考点,反过来,中心参考点决定每个对象相对于x-y轴上的中心位置的相对位置。因此,将相对值分配给将在合成音乐轨道中具有基于透视的定向声音的每个对象。因此,与位置序列0对象相比,在位置序列4处绘制的长笛将具有来自声音输出装置的右声道的更突出的输出,并且来自位置序列为-4的对象最终在左声道上具有突出声音,其中,位置序列0对象将在左声道和右声道两者处具有均等的输出。分配的序列顺序随着添加到绘图的更多对象以及它们与绘制的其它对象的相对比较而不断改变。

[0150]

图6b示出根据本公开的实施例的基于乐器的尺寸和位置的透视声音生成的示例。

[0151]

参照图6b,一旦使用映射器模块126映射乐器602(例如,小提琴、萨克斯管和电子琴),用户就与它们交互,并且用户根据它们的尺寸和位置产生透视声音效果,尺寸和位置序列也由映射器模块126分配。例如,基于对象/乐器的位置和尺寸,如果用户演奏小提琴,则声音呈现为从装置的左上侧被生成,这意味着装置的左侧上的声音将更突出;并且如果用户演奏萨克斯管,则声音呈现为从右上角被生成,这意味着装置的右侧上的声音将更突出。当用户与放置在装置中心的电子琴交互时,由于尺寸大于其它乐器,因此接收到的声音比其它乐器更响亮。因此,乐器基于其尺寸和位置来播放透视声音效果。

[0152]

图6c示出根据本公开的实施例的多个对象到服务器上的预定义对象的映射。

[0153]

参照图6c,基于绘图映射多个对象604。例如,用户想要使用不同的对象(诸如河流、刮着的风、孔雀声和手鼓声,其中,手鼓是膜质打击乐器)来创建交响乐。用户使用纸张和启用了相机的笔606绘制下雨场景,并且在该场景中,用户还绘制从右侧流向左侧的河流图像。此外,用户在页面的右侧绘制树,并且树由于大风而看起来像向右侧弯曲。用户还在页面的右侧绘制手鼓。启用了相机的笔606将绘制的对象的信息发送到服务器116,其中,服务器116识别绘制的对象并将对象映射到预定义对象,如雨、云、河流、风中的树和手鼓。

[0154]

图6d示出根据本公开的实施例的基于用户位置的透视声音生成。

[0155]

参照图6d,一旦用户的位置的映射处理608完成,用户就开始在他的耳戴式装置中收听雨的声音,并且同时,河流开始根据绘图中的方向制造水流透视声音效果。按照这样,该声音效果被感知为如图像中所示从远到近,并且按照这样,用户在他的耳戴式装置中感知到声音效果,像从左向右吹的大风以及树叶声音。

[0156]

根据本公开的实施例,在映射处理之后,手鼓的八度音阶被解锁,因此现在准备好作为实际手鼓进行使用。现在,用户开始通过他的手/手指演奏手鼓/与手鼓交互,并且它的声音开始与雨、风、树和河的声音合并。当用户开始演奏手鼓时,用户接收手鼓的基于透视的声音,其中,手鼓被绘制在页面的右侧。在该示例中,用户从他的耳戴式装置的右侧接收来自手鼓的定向透视声音。用户录制并保存雨、河、风和手鼓的透视音乐效果和节拍。

[0157]

图7a示出根据本公开的实施例的基于用户相对位置的透视声音生成。

[0158]

参照图7a,用户佩戴头戴式装置并且基于透视声音生成收听来自多个乐器的音乐700。如果用户想要收听多个乐器(例如,钢琴和萨克斯管)相对于他的头部相对位置的透视声音,则用户使用虚拟现实(vr)装置或头戴式装置等,其中,虚拟现实(vr)装置或头戴式装置等提供乐器(例如,萨克斯管和钢琴)的虚拟对象映射和3d定位。然后,用户开始与钢琴以及在钢琴的左侧的萨克斯管交互,因此将根据交互输入从扬声器听到透视声音。

[0159]

图7b示出根据本公开的实施例的基于用户的相对位置的透视声音生成的示例。

[0160]

参照图7b,示例702示出用户佩戴头戴式装置并且能够在用户在钢琴的方向上移动他的头部时借助于传感器来检测用户的相对位置。当头戴式装置检测到这种运动时,借助于所述传感器检测用户与装置的相对位置。因此,透视声音使钢琴声音比萨克斯管的声音更突出。

[0161]

图7c示出根据本公开的实施例的基于用户头部与头戴式装置的相对位置的透视声音生成的示例。

[0162]

参照图7c,示例704示出头戴式装置能够借助于传感器检测运动并且识别用户相对于装置上的乐器的相对位置。当用户将其头部从左侧转向右侧时,装置借助于传感器检测并识别用户的相对位置。因此,透视声音使萨克斯管的声音比钢琴的声音更突出。

[0163]

图8a示出根据本公开的实施例的乐器的打印图像到预定义乐器的映射。

[0164]

参照图8a,用户拿着乐器的打印模板(例如,纸上的电子琴)800,并且中间对象识别器装置(例如,头戴式增强现实装置)将捕获的图像/信息发送到服务器116。服务器116被配置为识别乐器的打印模板并将其与预定义对象(诸如电子琴)映射,还解锁其所有八度音阶。一旦八度音阶解锁处理完成,用户就开始交互/演奏乐器。

[0165]

图8b示出根据本公开的实施例的用户与乐器的打印模板交互。

[0166]

参照图8b,一旦打印模板到乐器的映射由服务器116完成并且八度音阶被解锁,用户就能够与乐器的打印模板交互802。所述与打印模板交互将为用户提供演奏乐器的真实沉浸式体验。

[0167]

图9a示出根据本公开的实施例的乐器的打印图像的映射。

[0168]

参照图9a,用户将乐器的图像900打印在纸上。包括使用对象映射模块110的头戴式增强现实(ar)装置的中间对象识别器装置将乐器的打印图像的信息发送到服务器116。服务器116识别装置并使用管理模块122中的映射器将其与预定义对象映射。映射器在映射所述乐器之后根据用户的要求解锁乐器的八度音阶。用户使用客户端模块132中的用户交互输入138与映射在装置上的乐器交互,并且对于每个输入,生成相应的声音。当用户与映射的乐器交互时,声音生成器模块112基于用户的输入生成声音。

[0169]

图9b示出根据本公开的实施例的在装置上的多个乐器的映射。

[0170]

参照图9b,可演奏多个乐器902。根据本公开的实施例,使用中间对象识别器装置(例如,头戴式ar装置)的用户识别在装置上的电子琴的打印图像。电子琴被映射在装置上,并且能够根据用户的输入产生音乐。用户还能够将另一装置(例如,萨克斯管)与电子琴组合在一起,以使用多个乐器产生交响乐。用户通过在纸上绘制萨克斯管发起,并且运动检测模块108(即,头戴式ar装置)将现场信息发送到对象映射模块110。对象映射模块110将预处理图像的信息发送到服务器116,反过来,服务器116识别对象并将信息发送到对对象进行映射的对象映射模块110。萨克斯管的所有八度音阶被解锁,用户现在可与萨克斯管交互,并且将从这种乐器生成声音。装置内的录制和重放模块104能够录制和重放已经播放的声音/交响乐。由于用户已经播放了电子琴的声音并且还播放了萨克斯管的声音,因此现在可融合乐器的两种声音以形成单个交响乐。

[0171]

根据本公开的实施例,用户还可添加诸如背景对象(包括流动河流、啁啾鸟、风等)的对象。用户还可添加具有打印图像、文本、绘制的图像等的乐器。从所有这些乐器和对象生成的音乐将被融合以创建单个音乐轨道/交响乐。来自多个乐器或对象的音乐创作技术为用户提供透视声音效果和沉浸式体验。

[0172]

图10a示出根据本公开的实施例的用户与va交互以映射乐器。

[0173]

参照图10a,用户将语音命令提供给va以在装置上绘制小提琴。va通过将用户的请求发送到服务器116来绘制小提琴,并将所述乐器映射到预定义对象。乐器的八度音阶也被实时解锁。

[0174]

根据本公开的实施例,va模块被配置为接收通过麦克风给出的语音命令,并处理该输入以识别对象/乐器请求。用户还可给出停止绘制整个乐器/对象的命令,并且可与部分地绘制的乐器交互。

[0175]

根据本公开的实施例,用户可减小或增大映射在装置上的乐器的尺寸,并且还可重新布置将影响装置的位置序列和尺寸序列的装置的位置和定位。

[0176]

图10b示出根据本公开的实施例的用户与va交互以映射另一乐器。

[0177]

参照图10b,根据本公开的实施例,用户将语音命令提供给va 1002以映射另一乐器,例如,萨克斯管。va通过将用户的请求发送到服务器116来绘制萨克斯管,并将乐器映射到预定义对象。乐器的八度音阶也被实时解锁。

[0178]

根据本公开的实施例,用户可根据他们的要求和偏好来调整和重新布置映射在装

置上的乐器。

[0179]

图10c示出根据本公开的实施例的用户对映射在装置上的多个乐器进行定位和缩放/调整尺寸。

[0180]

参照图10c,一旦乐器1004被映射,用户就可重新定位和重新缩放映射的乐器。例如,用户已经将小提琴和萨克斯管映射在同一装置上,因此用户可缩小两个乐器并将它们重新定位在同一装置上。用户基于要求将小提琴定位在装置的左上角并将其缩小到更小的尺寸。此外,用户将萨克斯管重新定位在装置的左上角,并将其重新定位为呈现比装置上的小提琴小。映射器模块126能够将位置和尺寸序列分配给每个识别出的对象,即,识别出的乐器、(小提琴和萨克斯管)。基于尺寸和位置,小提琴被标记为1,并且萨克斯管被标记为2。

[0181]

图10d示出根据本公开的实施例的用户与va交互以映射另一对象。

[0182]

参照图10d,在将小提琴和萨克斯管映射1006在装置上之后,用户还与va交互以加入电子琴。为了发起电子琴的映射,用户将语音命令提供给虚拟助理以添加电子琴。va通过将用户的请求发送到服务器116来绘制电子琴,并将所述乐器映射到预定义对象。乐器的八度音阶也被实时解锁。

[0183]

根据本公开的实施例,用户可根据他们的要求和偏好对装置上的映射的对象/乐器进行重新定位和重新缩放/调整尺寸。

[0184]

图10e示出根据本公开的实施例的用户重新定位三个映射的乐器并与三个映射的乐器交互。

[0185]

参照图10e,用户使三个对象(例如,三个乐器)映射到同一装置,并且用户可根据他们的偏好对映射的乐器进行重新定位和调整尺寸。用户将电子琴重新定位1008在装置的中间,使其尺寸最大。小提琴和萨克斯管分别被重新定位在左上角和右上角,小提琴的尺寸大于萨克斯管的尺寸。因此,基于尺寸,对乐器进行编号,即,电子琴为1,小提琴为2,并且最小的萨克斯管被标记为3。

[0186]

根据本公开的另一实施例,当用户与映射的对象(即,电子琴、小提琴和萨克斯管)交互时,一个接一个地与映射的对象交互、或与两个对象交互、或与这些对象一起交互,生成的声音基于透视。透视声音基于乐器的尺寸和位置被生成。例如,当生成小提琴声音时,左侧的声音将比右侧的声音更突出。然而,在用户与小提琴和萨克斯管两者交互的情况下,来自左侧的小提琴的声音将比萨克斯管的声音更响亮且更突出。因此,如果用户正在与小提琴和电子琴交互,则来自电子琴的声音将在中间突出,并且也将比小提琴的声音更响亮。

[0187]

根据本公开的实施例,由映射器模块126将乐器标记为1、2、3

……

等。映射器模块126将位置和尺寸序列分配给映射的对象。此外,映射器模块126还负责透视声音输入。

[0188]

尽管已经参照本公开的各种实施例示出和描述了本公开,但本领域技术人员将理解,在不脱离由所附权利要求及其等同物限定的本公开的精神和范围的情况下,可在其中进行形式和细节上的各种改变。

起点商标作为专业知识产权交易平台,可以帮助大家解决很多问题,如果大家想要了解更多知产交易信息请点击 【在线咨询】或添加微信 【19522093243】 与客服一对一沟通,为大家解决相关问题。

与客服一对一沟通,为大家解决相关问题。

此文章来源于网络,如有侵权,请联系删除

热门咨询

热门咨询

tips

商标分类

商标分类  商标转让

商标转让