一种基于语谱图合成的语音转换方法与流程

2021-01-28 12:01:45|

2021-01-28 12:01:45| 360|

360| 起点商标网

起点商标网

[0001]

本发明涉及语音转换技术领域,尤其涉及一种基于语谱图合成的语音转换方法。

背景技术:

[0002]

语音转换技术是指将源说话人的身份信息转换为目标说话人的身份信息,同时保持语音内容不变,简单地说就是将一个说话人(称之为源)的声音,通过某种手段进行变换,使其听起来仿佛是另一个说话人(称之为目标)说的话。语音转换属于交叉性的学科分支,其内容既涉及到语音学、语义学及心理声学等领域的知识,又涵盖语音信号处理领域的各个方面,如语音的分析与合成、说话人识别、语音编码和增强等。现阶段,语音转换技术在医疗服务、保密通信及生活娱乐的方面有着非常重要的应用。目前,语音转换可以大致分为两类,一类是受监督的,另一类是无监督的。受监督的语音转换已经取得了较好的成果,但是需要源语音与目标语音之间相应语音帧对齐,如果源语音与目标语音之间有巨大差异,就无法达到较好的转换效果,这也限制了其应用推广。

[0003]

因此,本发明提出一种基于语谱图合成的语音转换方法。

技术实现要素:

[0004]

本发明的目的是针对现有技术的缺陷,提供了一种基于语谱图合成的语音转换方法。

[0005]

为了实现以上目的,本发明采用以下技术方案:

[0006]

一种基于语谱图合成的语音转换方法,包括:

[0007]

s1.将源语音和目标语音的语谱图分解为内容语谱图和说话人语谱图,并将内容语谱图和说话人语谱图分别输入超深度卷积神经网络中进行处理,分别得到内容语谱图的语义内容信息和说话人语谱图的说话人身份信息;

[0008]

s2.将得到的语义内容信息和说话人身份信息映射到特征空间,分别得到语义内容信息的特征矩阵直方图和说话人身份信息的特征矩阵直方图;

[0009]

s3.将得到的语义内容信息的特征矩阵直方图和说话人身份信息的特征矩阵直方图输入直方图匹配hdain层中进行匹配,得到目标特征矩阵;

[0010]

s4.基于生成框架将得到的目标特征矩阵转换为目标语谱图,其中,转换后的目标语谱图包括内容语谱图的语义内容信息和说话人语谱图的说话人身份信息;

[0011]

s5.将转换得到的目标语谱图通过生成对抗网络转换为语音波形输出。

[0012]

进一步的,所述步骤s1具体为:

[0013]

将源语音的语谱图c和目标语音的语谱图s分别作为内容语谱图和说话人语谱图输入超深度卷积神经vgg网络中,超深度卷积神经vgg网络从源语音的语谱图c中提取语义内容信息,从目标语音的语谱图s中提取说话人身份信息,分别得到内容语谱图的语义内容信息和说话人语谱图的说话人身份信息。

[0014]

进一步的,所述步骤s2具体为:

[0015]

分别对语义内容信息和说话人身份信息进行编码,得到与语义内容信息和说话人身份信息对应的语义内容信息的特征矩阵f(c)和说话人身份信息的特征矩阵f(s)。

[0016]

进一步的,所述步骤s3具体为:

[0017]

将得到的语义内容信息的特征矩阵f(c)和说话人身份信息的特征矩阵f(s)馈送到通过直方图匹配的hdain层,hdain层将语义内容信息的特征矩阵f(c)和说话人身份信息的特征矩阵f(s)进行匹配,从而获得目标特征矩阵,表示为:

[0018]

y=hadin(f(c),f(s))

[0019]

其中,y表示目标特征矩阵。

[0020]

进一步的,所述步骤s4具体为:

[0021]

通过生成框架镜像处理得到的目标特征矩阵,对随机的生成函数g进行训练,将目标特征矩阵转为目标语谱图,表示为:

[0022]

o=g(y)

[0023]

其中,o表示生成的目标语谱图;g(y)表示目标特征矩的函数。

[0024]

进一步的,所述步骤s4中生成框架具体为:

[0025]

使用预训练的超深度卷积神经vgg网络计算出重建的语义内容信息损失与说话人身份信息损失,并训练生成框架。

[0026]

进一步的,所述内容损失与说话人损失具体为:

[0027]

使用生成的目标语谱图处理目标特征矩阵,并计算hdain层输出语义内容信息损失函数,表示为:

[0028]

l

c

=||f(g(y)-y)||

[0029]

其中,l

c

表示语义内容信息损失函数;

[0030]

通过匹配常规的实例统计信息获得说话人身份信息损失函数,表示为:

[0031][0032][0033]

l

s

=l

s1

+l

s2

[0034]

其中,l

s

表示说话人身份信息损失函数;t表示超深度卷积神经vgg网络中relu1_1,relu2_1,relu3_1,relu4_1层中的一层;μ表示目标说话人语谱图的均值;σ表示目标说话人语谱图的方差。

[0035]

进一步的,所述步骤s4还包括:

[0036]

将逐层输出目标特征矩阵重新映射为具有梯度的特殊特征图,将特殊特征图与生成的目标语谱图进行匹配得到直方图损失函数,表示为:

[0037][0038][0039]

其中,l

h

表示直方图损失函数;t表示超深度卷积神经vgg网络中relu1_1,relu4_1

层中的一层;h(o

ij

)表示通过直方图映射后的特征图;o

ij

表示原始输出的特征图;表示原始输出特征图的最大值;表示原始输出特征图的最小值;delta表示直方图间隔参数。

[0040]

进一步的,所述步骤s4中还包括:

[0041]

计算目标语谱图的总损失函数,表示为:

[0042]

l=l

c

+l

s

+l

h

[0043]

其中,l表示总损失函数。

[0044]

进一步的,所述步骤s5中将转换得到的目标语谱图通过生成对抗网络转换为语音波形输出,表示为:

[0045]

x=g(g(y))

[0046]

其中,x表示语音波形。

[0047]

与现有技术相比,本发明具有以下优点:

[0048]

(1)通过hdain层的应用,可以将语谱图的内容信息与身份信息分开进行处理,并且可以实现无监督的语音转换,从而解决了需要大量并行数据的弊端,使语音转换的应用范围更加广泛与灵活。

[0049]

(2)本发明的方法基于语谱图进行语音转换,语音波形不参与直接转换,使得数据收集十分容易。

[0050]

(3)通过gan模型进行语谱图与语音之间的转换,可以得到质量更高的语音,并且用时更短。

附图说明

[0051]

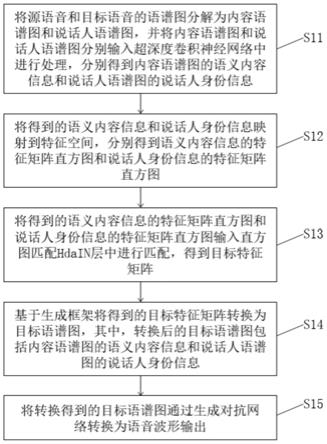

图1是实施例一提供的一种基于语谱图合成的语音转换方法流程图;

[0052]

图2是实施例一提供的基于语谱图合成的语音转换系统框架结构图;

[0053]

图3是实施例一提供的gan模型生成器结构图;

[0054]

图4是实施例一提供的gan模型鉴别器结构图。

具体实施方式

[0055]

以下通过特定的具体实例说明本发明的实施方式,本领域技术人员可由本说明书所揭露的内容轻易地了解本发明的其他优点与功效。本发明还可以通过另外不同的具体实施方式加以实施或应用,本说明书中的各项细节也可以基于不同观点与应用,在没有背离本发明的精神下进行各种修饰或改变。需说明的是,在不冲突的情况下,以下实施例及实施例中的特征可以相互组合。

[0056]

本发明的目的是针对现有技术的缺陷,提供了一种基于语谱图合成的语音转换方法。

[0057]

本发明提出通过直方图匹配的实例归一化(histogram-matched instance normalization,hdain)将源语音和目标语音的语谱图分解为内容语谱图和说话人语谱图分别处理,无需对齐语音。

[0058]

实施例一

[0059]

本实施例提供一种基于语谱图合成的语音转换方法,如图1-2所示,包括步骤:

[0060]

s11.将源语音和目标语音的语谱图分解为内容语谱图和说话人语谱图,并将内容语谱图和说话人语谱图分别输入超深度卷积神经网络中进行处理,分别得到内容语谱图的语义内容信息和说话人语谱图的说话人身份信息;

[0061]

s12.将得到的语义内容信息和说话人身份信息映射到特征空间,分别得到语义内容信息的特征矩阵直方图和说话人身份信息的特征矩阵直方图;

[0062]

s13.将得到的语义内容信息的特征矩阵直方图和说话人身份信息的特征矩阵直方图输入直方图匹配hdain层中进行匹配,得到目标特征矩阵;

[0063]

s14.基于生成框架将得到的目标特征矩阵转换为目标语谱图,其中,转换后的目标语谱图包括内容语谱图的语义内容信息和说话人语谱图的说话人身份信息;

[0064]

s15.将转换得到的目标语谱图通过生成对抗网络转换为语音波形输出。

[0065]

本实施例将源语音和目标语音的语谱图作为输入,采用超深度卷积神经网络——视觉几何小组(visual geometry group 19,vgg-19)对其进行处理,从内容语谱图中提取语义内容信息,从说话人语谱图中提取说话人身份信息,并将其映射到特征空间。随后将内容特征矩阵的直方图与说话人信息特征矩阵的直方图在hdain层进行匹配得到目标特征矩阵,再通过生成框架将目标特征矩阵转换为目标语谱图,转换后的语谱图具有内容语谱图的语义内容和目标说话人语谱图的身份信息,并将生成的目标语谱图通过生成对抗网络(generative adversarial network,gan)转换为语音波形输出。

[0066]

本实施例通过计算目标语谱图的特征分别与内容语谱图的特征、说话人语谱图的特征之间的欧氏距离得到内容损失l

c

与说话人损失l

s

,通过计算原始输出与直方图映射输出的欧氏距离得到直方图损失l

h

。整个系统的损失函数是由内容损失l

c

、说话人损失l

s

以及直方图损失l

h

构成,从而可以通过最小化损失找到最优匹配进行转换,达到生成高质量合成语谱图的目的。本发明的语音转换系统结构如图2所示。

[0067]

语义内容信息具体为:

[0068]

本实施例使用了19层vgg网络的16个卷积层和5个池化层的规范化版本提供的特征空间,通过缩放权重来对网络进行归一化,以使每个卷积滤波器在图像和位置上的平均激活次数等于1。

[0069]

通常,网络中的每一层都定义了一个非线性滤波器组,其复杂度随网络中该层位置的升高而增加。因此,给定的内容输入语谱图通过对该图像的滤波器响应在卷积神经网络的每一层中进行编码,具有n

t

个离散滤波器的层具有n

t

个特征图,每个特征图的大小均为m

t

,其中m

t

是特征图的高度乘以宽度。因此,层t中的响应可以存储在矩阵中,其中是层t中位置j处第i个滤波器的激活。为了可视化在不同层上编码的图像信息,可以对白噪声图像执行梯度下降,以找到与原始图像的特征响应相匹配的另一幅图像。令c和o为原始源说话人语谱图和生成的语谱图,令c

t

和o

t

为它们在层t中的各自特征表示。然后,本实施例定义两个特征表示之间的误差损失为:

[0070][0071]

通过计算内容损失的导数确定层t中的激活,内容损失的导数为:

[0072][0073]

从中可以使用标准误差反向传播来计算相对于图像o的梯度。因此,我们可以更改初始随机图像o,直到它在卷积神经网络的特定层中生成与原始图像c相同的响应为止。

[0074]

当对卷积神经网络进行内容识别训练时,它们会形成图像表示,从而使内容信息沿处理层次的升高越来越清晰。因此,网络中的高层根据对象及其在输入图像中的排列来捕获高级内容,但并不会很大程度地限制重建的精确像素值。相比之下,从较低层进行的重建只是简单地复制了原始图像的精确像素值。因此,我们将网络高层中的特征响应称为内容表示f(c)。

[0075]

说话人身份信息具体为:

[0076]

为了获得输入语谱图的说话人表示,本实施例使用了一个特征空间来捕获说话人身份信息。可以在vgg网络任何层的滤波器响应上构建此特征空间,它由不同滤波器响应之间的相关关系组成,其中对特征图的空间范围求期望。这些特征相关性由gram矩阵给出,其中是第t层中矢量化特征图i和j之间的内积:

[0077][0078]

因为包括多层的特征相关性,所以可以获得输入图像平稳、多尺度的表示,该表示捕获了图像包含的说话人信息,但不捕获全局信息。因此可以通过构建与给定输入说话人语谱图的说话人表示相匹配的图像,来可视化这些在vgg网络不同层上构建的说话人特征空间所捕获的信息。这是通过使用白噪声图像的梯度下降来最小化原始图像的gram矩阵与要生成的图像的gram矩阵之间的均方距离来实现的。

[0079]

令s和o为原始目标说话人语谱图和生成的语谱图,而s

t

和g

t

分别表示层t中的说话人信息。那么,t层的损失为:

[0080][0081]

总损失为:

[0082][0083]

其中,w

t

表示每一层对总损失的贡献的加权因子。关于层t中的激活,可以通过分析e

t

的导数来计算:

[0084][0085]

使用标准误差反向传播可以很容易地计算出e

l

相对于图像o的梯度。

[0086]

因此将可视化后的说话人信息称之为说话人表示f(s)。

[0087]

生成对抗网络gan模型具体为:

[0088]

本实施例采用gan模型将语谱图转化为原始语音波形。该模型中的生成器是一个

完全卷积的前馈网络,由于语谱图位于较低的256倍时间分辨率,所以使用了一系列转置的卷积层来对输入序列进行上采样。每个上采样层是一个转置卷积,内核大小是步幅的两倍。256x上采样分4个阶段进行,分别是8x,8x,2x和2x上采样。每个转置的卷积层后面是一堆带有膨胀卷积的剩余块,每个剩余块都具有三层,其扩散层1、3和9的核大小为3,总接收场为27个时间步长。其结构如图3所示。

[0089]

本实施例采用具有3个鉴别器(d

1

,d

2

,d

3

)的多尺度架构,这些鉴别器具有相同的网络结构,但在不同频率的音频运行。d

1

以原始音频的频率运行,而d

2

,d

3

以分别降频2倍和4倍的原始音频运行。下采样是使用具有内核大小为4的跨步平均池执行的。音频具有不同级别的结构,因此可以激发不同比例的多个鉴别器。每个单独的鉴别器都是基于马尔可夫窗口的鉴别器,由一系列大内核的跨步卷积层组成。其结构如图4所示。

[0090]

语谱图转换方法具体为:

[0091]

本实施例通过提取内容语谱图的语义内容和说话人语谱图的身份信息,对其特征图进行映射并用直方图匹配,从而合成高质量的转换后语谱图,最后用gan模型将语谱图转化为原始语音波形,得到转换后的语音,即具有目标说话人的身份信息但不改变源说话人的内容。算法的具体过程如下。

[0092]

在步骤s11中,将源语音和目标语音的语谱图分解为内容语谱图和说话人语谱图,并将内容语谱图和说话人语谱图分别输入超深度卷积神经网络中进行处理,分别得到内容语谱图的语义内容信息和说话人语谱图的说话人身份信息。

[0093]

将源说话人的语谱图c和目标说话人的语谱图s分别作为内容语谱图和说话人语谱图输入vgg网络。vgg网络从源说话人的语谱图c中提取语义内容,同时从目标语音的语谱图s中提取说话人身份信息,分别得到内容语谱图的语义内容信息和说话人语谱图的说话人身份信息。

[0094]

在步骤s12中,将得到的语义内容信息和说话人身份信息映射到特征空间,分别得到语义内容信息的特征矩阵直方图和说话人身份信息的特征矩阵直方图。

[0095]

分别对语义内容信息和说话人身份信息进行编码,得到与语义内容信息和说话人身份信息对应的语义内容信息的特征矩阵f(c)和说话人身份信息的特征矩阵f(s)。

[0096]

在步骤s13中,将得到的语义内容信息的特征矩阵直方图和说话人身份信息的特征矩阵直方图输入直方图匹配hdain层中进行匹配,得到目标特征矩阵。

[0097]

将获得的特征矩阵f(c)和f(s)馈送到通过直方图匹配的hdain层,该层将内容特征矩阵的直方图与样式特征矩阵的直方图进行匹配,从而获得目标特征矩阵:

[0098]

y=hadin(f(c),f(s))

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(7)

[0099]

其中,y表示目标特征矩阵。

[0100]

在步骤s14中,基于生成框架将得到的目标特征矩阵转换为目标语谱图,其中,转换后的目标语谱图包括内容语谱图的语义内容信息和说话人语谱图的说话人身份信息。

[0101]

通过生成框架镜像处理目标特征矩阵,对随机的生成函数g进行训练,以将目标矩阵转为目标语谱图,即:

[0102]

o=g(y)

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(8)

[0103]

使用预训练的vgg-19网络计算出重建的内容损失与说话人损失,从而训练生成框架。关于内容损失函数l

c

,我们使用生成的图像来处理其特征并计算hdain输出y,即:

[0104]

l

c

=||f(g(y)-y)||

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(9)

[0105]

我们通过匹配常规的实例统计信息来获得说话人信息损失函数l

s

,即:

[0106][0107][0108]

l

s

=l

s1

+l

s2

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(12)

[0109]

此处,t表示vgg-19中relu1_1,relu2_1,relu3_1,relu4_1层中的一层。

[0110]

根据值从原始输出激活中找出与从而确定直方图间隔delta,即:

[0111][0112]

首先将逐层输出特征图重新映射为具有梯度的特殊特征图。然后我们将它们与生成的图像进行匹配以获得直方图损失函数l

h

,即:

[0113][0114]

其中,t表示vgg-19中relu1_1,relu4_1层中的一层。

[0115]

在步骤s15中,将转换得到的目标语谱图通过生成对抗网络转换为语音波形输出。

[0116]

得到高质量的目标语谱图后,通过gan网络将语谱图转化为原始语音波形x,即:

[0117]

x=g(g(y))

ꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀꢀ

(16)

[0118]

其中,x表示语音波形。

[0119]

与现有技术相比,本实施例具有以下优点:

[0120]

(1)通过hdain层的应用,可以将语谱图的内容信息与身份信息分开进行处理,并且可以实现无监督的语音转换,从而解决了需要大量并行数据的弊端,使语音转换的应用范围更加广泛与灵活。

[0121]

(2)本实施例的方法基于语谱图进行语音转换,语音波形不参与直接转换,使得数据收集十分容易。

[0122]

(3)通过gan模型进行语谱图与语音之间的转换,可以得到质量更高的语音,并且用时更短。

[0123]

注意,上述仅为本发明的较佳实施例及所运用技术原理。本领域技术人员会理解,本发明不限于这里所述的特定实施例,对本领域技术人员来说能够进行各种明显的变化、重新调整和替代而不会脱离本发明的保护范围。因此,虽然通过以上实施例对本发明进行了较为详细的说明,但是本发明不仅仅限于以上实施例,在不脱离本发明构思的情况下,还可以包括更多其他等效实施例,而本发明的范围由所附的权利要求范围决定。

起点商标作为专业知识产权交易平台,可以帮助大家解决很多问题,如果大家想要了解更多知产交易信息请点击 【在线咨询】或添加微信 【19522093243】 与客服一对一沟通,为大家解决相关问题。

与客服一对一沟通,为大家解决相关问题。

此文章来源于网络,如有侵权,请联系删除

热门咨询

热门咨询

tips

商标分类

商标分类  商标转让

商标转让