车辆的乘员保护系统的制作方法

2021-02-03 16:02:23|

2021-02-03 16:02:23| 288|

288| 起点商标网

起点商标网

[0001]

本发明涉及车辆的乘员保护系统。

背景技术:

[0002]

在车辆上设有例如在碰撞时执行针对乘坐于车辆的乘员的保护控制的乘员保护装置。乘员保护装置当检测到由碰撞引起的冲击时,就利用座椅安全带来约束坐在座椅上的乘员,或者在座椅的周围展开气囊,吸收从座椅倾倒或离开座椅的乘员的冲击。

[0003]

现有技术文献

[0004]

专利文献

[0005]

专利文献1:日本特开平11-043009号公报

技术实现要素:

[0006]

发明要解决的课题

[0007]

可是,车辆的碰撞不限于例如正面碰撞或侧面碰撞。例如,也有时是其他移动体在侧面与车辆发生碰撞,或者其他移动体从斜前方向与车辆发生碰撞。

[0008]

因此,优选乘员保护装置能够尽最大可能地应对多种多样的碰撞形态。另外,优选乘员保护装置能够尽可能地根据碰撞时的乘员的乘车状态,进行适合各种乘车状态的乘员保护。

[0009]

在专利文献1中,为了监视乘坐于车辆的乘员,在车辆上设有ccd设备等拍摄设备。考虑将这种拍摄设备用于乘员保护。

[0010]

这样,在车辆中,要求能够执行与映入从拍摄设备输出的拍摄图像中的乘员对应的保护控制。

[0011]

用于解决课题的技术方案

[0012]

本发明的车辆的乘员保护系统具有:拍摄设备,其可拍摄乘坐于车辆的乘员;乘员监视装置,其基于从所述拍摄设备输出的拍摄图像来监视乘员;乘员保护装置,其基于所述乘员监视装置的监视来执行与乘坐于所述车辆的乘员对应的保护控制,其中所述乘员监视装置在不能基于从所述拍摄设备输出的拍摄图像来判定乘员在所述车辆内的乘车状态的情况下,切换从所述拍摄设备输出的拍摄图像的拍摄范围。

[0013]

优选地,所述乘员监视装置可以在不能基于从所述拍摄设备输出的拍摄图像来判定乘员在所述车辆内的乘车状态的情况下,将从所述拍摄设备输出的拍摄图像的拍摄范围切换为比不能判定的拍摄图像窄。

[0014]

优选地,所述拍摄设备可以具有:拍摄元件,其可拍摄乘坐于车辆的乘员;生成部,其根据所述拍摄元件的拍摄图像,生成由所述乘员监视装置指示的图像;评价部,其基于图像整体,对由所述生成部生成的图像的画质进行评价;以及输出部,其基于所述评价部的评价,修正由所述生成部生成的图像,并作为拍摄图像而输出。

[0015]

优选地,所述乘员监视装置可以在预测到所述车辆的碰撞时,在不能基于从所述

拍摄设备输出的第一拍摄图像来判定乘员在所述车辆内的乘车状态的情况下,以拍摄比所述第一拍摄图像的第一拍摄范围窄的第二拍摄范围的方式切换从所述拍摄设备输出的拍摄图像。

[0016]

优选地,所述乘员监视装置可以在不能基于所述第二拍摄范围的第二拍摄图像来判定乘员在所述车辆内的乘车状态的情况下,以拍摄比所述第二拍摄范围窄的第三拍摄范围的方式切换从所述拍摄设备输出的拍摄图像。

[0017]

优选地,所述乘员监视装置可以在不能基于所述第三拍摄范围的第三拍摄图像来判定乘员在所述车辆内的乘车状态的情况下,以将所述第三拍摄范围分割为多个进行拍摄的方式切换从所述拍摄设备输出的拍摄图像。

[0018]

优选地,所述乘员监视装置可以在直到所述乘员保护装置执行基于所述车辆的碰撞检测的乘员的保护控制为止还有时间的情况下,通过所述拍摄设备,重复进行将所述第三拍摄范围分割为多个进行拍摄的处理。

[0019]

优选地,所述乘员监视装置可以在较窄地切换从所述拍摄设备输出的拍摄图像的拍摄范围时,提高所述拍摄设备输出拍摄图像的输出帧率。

[0020]

发明效果

[0021]

在本发明中,乘员监视装置在不能基于从拍摄设备输出的拍摄图像来判定乘员在车辆内的乘车状态的情况下,切换从拍摄设备输出的拍摄图像的拍摄范围。通过切换拍摄范围,难以在拍摄图像中出现乘员以外的物体,能够期待拍摄设备可以适当地拍摄乘坐于车辆的乘员。其结果是,乘员监视装置能够基于切换后的拍摄图像,判定乘员在车辆内的乘车状态。另外,乘员保护装置能够基于更准确地判定出了车辆内的乘车状态的乘员监视装置的监视,执行与乘坐于车辆的乘员对应的保护控制。

[0022]

在车辆中,拍摄乘员的拍摄设备基本上在车内设置为固定的位置及朝向。因此,例如在拍摄范围内出现了朝阳或夕阳的情况下,图像整体有可能变白(白飛

びする

)。在图像整体变白的情况下,难以基于其拍摄图像来正确地判定乘员在车辆内的乘车状态。在这种情况下,会基于不正确的判定,执行对乘员的保护控制,不能适当地对乘坐于车辆的乘员执行保护控制的可能性升高。

[0023]

与此相对,在本实施方式中,在不能基于从拍摄设备输出的拍摄图像来判定乘员在车辆内的乘车状态的情况下,切换从拍摄设备输出的拍摄图像的拍摄范围。例如,在不能基于从拍摄设备输出的拍摄图像来判定乘员在车辆内的乘车状态的情况下,将从拍摄设备输出的拍摄图像的拍摄范围切换为比不能判定的拍摄图像窄。由此,即使拍摄乘员的拍摄设备在车内设置为固定的位置及朝向,乘员监视装置也能够基于切换后的例如无朝阳或夕阳的映入的拍摄图像,正确地判定乘员在车辆内的乘车状态。能够基于正确的判定,执行对乘员的保护控制,能够对乘坐于车辆的乘员适当地执行保护控制。通过使用本实施方式的乘员监视装置,乘员保护装置能够在多种多样的碰撞形态中,根据碰撞时的乘员的乘车状态等,执行适合该乘车状态的乘员保护。

附图说明

[0024]

图1是作为本发明之一例的实施方式的汽车的说明图。

[0025]

图2是设置于图1的汽车中的乘员保护装置之一例的结构图。

[0026]

图3(a)-(b)是图2的乘员保护装置为执行与乘员的乘车状态等对应的最佳保护控制所需要的信息之一例的说明图。

[0027]

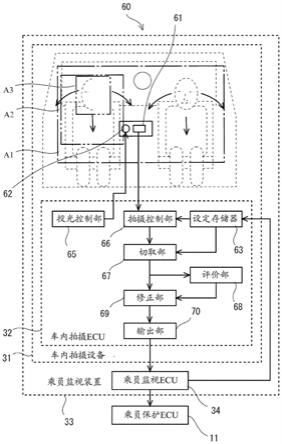

图4是设置于图1的汽车中的控制系统之一例的结构图。

[0028]

图5是包含图4的车内拍摄设备及乘员监视装置在内的乘员保护系统的主要结构图。

[0029]

图6是图4的乘员监视ecu的拍摄控制的流程图。

[0030]

图7(a)-(c)是在车内拍摄设备的通常拍摄图像中映射出太阳的情况的说明图。

[0031]

图8(a)和(b)是在驾驶员的头部拍摄图像中头部的一部分欠缺地映射出的情况的说明图。

[0032]

符号说明

[0033]

1

…

汽车(车辆)

[0034]

3

…

车室

[0035]

10

…

乘员保护装置

[0036]

11

…

乘员保护ecu

[0037]

30

…

控制系统

[0038]

31

…

车内拍摄设备

[0039]

32

…

车内拍摄ecu

[0040]

33

…

乘员监视装置

[0041]

34

…

乘员监视ecu

[0042]

35

…

系统计时器

[0043]

42

…

碰撞预测ecu

[0044]

60

…

乘员保护系统

[0045]

61

…

拍摄元件

[0046]

63

…

设定存储器

[0047]

66

…

拍摄控制部

[0048]

67

…

切取部

[0049]

68

…

评价部

[0050]

69

…

修正部

[0051]

70

…

输出部

[0052]

a1

…

通常拍摄范围

[0053]

a2

…

上身拍摄范围

[0054]

a3

…

头部拍摄范围

[0055]

a4

…

微小范围

具体实施方式

[0056]

下面,基于附图对作为本发明之一例的实施方式进行说明。

[0057]

图1是作为本发明之一例的实施方式的汽车1的说明图。汽车1是车辆之一例。

[0058]

图1的汽车1在形成于车身2的车室3内乘坐有包含驾驶员在内的多个乘员。乘车的乘员坐在设置于车室3的座椅4上。在这种状态下,通过驾驶员操作汽车1的方向盘、踏板、操

作杆之类的操作设备39,汽车1进行行驶移动。另外,汽车1可以基于目的地的设定等,通过自主的自动驾驶,进行行驶移动。

[0059]

在这种汽车1中,有可能在移动中或停车中与其他汽车1等其他运动物体发生接触或碰撞。如图1的多个箭头所示,在汽车1上输入有由从前后左右斜向的全方位与其他运动物体发生碰撞引起的冲击。在这种情况下,基本上就座于座椅4的乘员的上身基本上向冲击的输入方向倾倒。

[0060]

图2是设置于图1的汽车1的乘员保护装置10之一例的结构图。

[0061]

图2的乘员保护装置10具有:乘员保护ecu11、保护存储器12、多个座椅安全带13、多个安全带致动器14、多个气囊15、多个基座部件16、多个气囊致动器(ab致动器)17、多个充气机18。

[0062]

一组座椅安全带13及安全带致动器14构成一个座椅安全带部件19。

[0063]

一组气囊15、基座部件16、气囊致动器17、多个充气机18构成一个气囊部件20。

[0064]

座椅安全带部件19及气囊部件20设置于每个座椅4或每个座椅4的就座位置。在图2中,以与左右一对座椅4对应的方式设有两组安全带部件19和两组气囊部件20。

[0065]

座椅安全带13是挂在就座于座椅4的乘员的腰部及上身的前边的安全带。

[0066]

安全带致动器14对座椅安全带13施加可变的张力。施加有张力的座椅安全带13以将乘员的腰部及上身按压于座椅4的方式发挥功能。

[0067]

气囊15是通过高压气体而瞬时展开的袋体。

[0068]

多个充气机18分别产生向气囊15注入的高压气体。在使多个充气机18都动作的情况下,气囊15以高压展开。在使一个充气机18动作的情况下,气囊15以低压展开。通过使多个充气机18的动作起始定时相互错开,能够使气囊15以与它们一齐动作的情况不同的压力变化而展开。

[0069]

在基座部件16上安装有气囊15,以折叠的状态收纳气囊15。此外,多个充气机18也可以设置于基座部件16。

[0070]

气囊致动器17驱动基座部件16,调节基座部件16的位置或朝向。在基座部件16例如以可向车宽方向、前后方向、上下方向移动的方式安装于车身2的情况下,气囊致动器17滑动驱动基座部件16而调节其位置。

[0071]

在基座部件16可旋转地设置在安装位置的情况下,气囊致动器17旋转驱动基座部件16而调节其朝向。

[0072]

保护存储器12例如是半导体存储器。保护存储器12记录用于乘员保护的程序及设定数据等。

[0073]

乘员保护ecu11例如是微型计算机。乘员保护ecu11读入并执行记录于保护存储器12的程序。由此,乘员保护ecu11作为乘员保护控制部发挥功能。

[0074]

作为乘员保护控制部的乘员保护ecu11当预测到了汽车1的碰撞,或检测到了汽车1的碰撞时,执行乘员保护控制。乘员保护ecu11可以基于检测到汽车1的碰撞或检测到不可避免,执行乘员保护控制。届时,乘员保护ecu11可以基于图1所示的冲击的输入位置及强度、车速、就座于座椅4的乘员的上身及头部的位置及朝向等,执行与乘坐的乘员对应的保护控制。例如,乘员保护ecu11为了保护乘员,使气囊15向乘员的上身倾倒的方向展开。乘员保护ecu11将与冲击的强度对应的张力施加于座椅安全带部件19的座椅安全带13。由此,在

碰撞时,通过座椅安全带13来支撑倾倒乘员的上身,尽管如此,也能够由展开的气囊吸收倾倒乘员的上身的冲击。

[0075]

通过执行这种控制,乘员保护装置10能够应对多种多样的碰撞形态,从而根据碰撞时的乘员的乘车状态,执行适合该乘车状态的最佳的乘员保护。

[0076]

图3(a)-(b)是图2的乘员保护装置10为实现与乘员乘车状态等对应的最佳保护控制所需要的信息之一例的说明图。

[0077]

图3(a)是碰撞预测信息。图3(a)的碰撞预测信息包含冲击的输入位置、冲击的强度、车速。冲击的输入位置、强度的预测信息例如可基于由车外拍摄设备47拍摄的与其他运动物体的相对移动来预测。本车的车速可通过车速传感器45来检测。

[0078]

图3(b)是乘员信息。图3(b)的乘员信息例如包含驾驶员等乘员的上身的位置(就座位置)、上身的朝向、头部的位置、头部的朝向。这些信息可由乘员监视装置33生成,该乘员监视装置33基于乘坐于汽车1的乘员的拍摄图像,监视乘员。

[0079]

在能够取得这些信息的情况下,乘员保护ecu11能够应对多种多样的碰撞形态,从而根据碰撞时的乘员的乘车状态,执行适合该乘车状态的最佳的乘员保护。

[0080]

相反,在连这些信息的一部分都不能取得的情况下,乘员保护ecu11例如仅执行与碰撞时的乘员的乘车状态无关的碰撞形态对应的通常的乘员保护。这种通常的乘员保护有可能不一定是与乘员的乘车状态对应的最佳保护,有可能变成最小公倍数的保护。

[0081]

这样,乘员保护装置10为了执行高度的乘员保护,不仅需要对车身2的冲击的输入位置及强度的信息,还需要其他例如与碰撞时的乘员的就座状态有关的高精度检测到的信息。

[0082]

图4是设置于图1的汽车1的控制系统30之一例的结构图。

[0083]

图4的控制系统30具有:车内拍摄设备31的车内拍摄ecu32、乘员监视装置33的乘员监视ecu34、系统计时器35、乘员保护装置10的乘员保护ecu11、通过无线通信网络36与信息服务器37进行通信的通信设备38、操作设备39、驾驶辅助ecu40、自动驾驶ecu41、碰撞预测ecu42、传感器ecu43、及将它们连接在一起的车载网络44。

[0084]

车载网络44例如是基于can之类的标准的车辆用的数据通信网络。

[0085]

系统计时器35测量时刻、时间。系统计时器35将所测量的时刻或经过时间的数据输出到车载网络44。

[0086]

在传感器ecu43上连接有例如车速传感器45、加速度传感器46、车外拍摄设备47。传感器ecu43控制这些传感器的动作,将例如由车外拍摄设备47检测到的车外的拍摄图像、由加速度传感器46检测的汽车1的加速度之类的信息输出到车载网络44。

[0087]

碰撞预测ecu42基于车外的拍摄图像、车速等,预测汽车1的碰撞。碰撞预测ecu42将碰撞预测数据输出到车载网络44。

[0088]

通信设备38与未图示的基站进行无线通信,通过无线通信网络36,与信息服务器37进行数据收发。通信设备38可以从信息服务器37取得例如地图数据、交通信息。

[0089]

操作设备39是设置于车身2而由乘员进行操作的操作设备39。作为操作设备39,有例如转向用的方向盘、加速踏板、制动踏板、变速杆。

[0090]

驾驶辅助ecu40取得由操作设备39根据乘员的操作而生成的操作数据,生成与操作数据对应的行驶控制数据。驾驶辅助ecu40通过车载网络44,向控制未图示的发动机的动

作的驱动源ecu、控制未图示的制动装置的制动ecu、控制未图示的转向装置的操舵ecu输出行驶控制数据。由此,汽车1根据乘员的操作进行行驶移动。

[0091]

自动驾驶ecu41基于到目的地为止的路线设定等,使汽车1行驶到目的地。自动驾驶ecu41根据要行驶的道路的行驶环境,生成控制汽车1的移动的行驶控制数据。自动驾驶ecu41通过车载网络44,向上述的驱动源ecu、制动ecu、操舵ecu输出行驶控制数据。由此,汽车1不通过乘员的操作,即可自主地行驶移动到目的地。

[0092]

车内拍摄ecu32控制车内拍摄设备31的动作,拍摄乘坐于汽车1的乘员。车内拍摄ecu32将由车内拍摄设备31拍摄到的图像输出到车载网络44。

[0093]

乘员监视ecu34控制乘员监视装置33的动作。乘员监视ecu34例如通过车载网络44,向车内拍摄ecu32输出拍摄的设定数据。乘员监视ecu34取得从车内拍摄设备31输出的拍摄图像,基于已取得的拍摄图像,监视乘坐于汽车1的乘员。另外,乘员监视ecu34在预测到了汽车1的碰撞的情况下,将乘员的乘车状态输出到车载网络44。

[0094]

乘员保护ecu11控制乘员保护装置10的动作。乘员保护ecu11在预测到了汽车1的碰撞的情况下,进而在由加速度传感器46检测到了由汽车1的碰撞引起的加速度的情况下,执行保护乘员等的控制。乘员保护ecu11基于检测到汽车1的碰撞或检测到碰撞的不可避免,执行用于保护乘员的最终控制。而且,乘员保护ecu11在可得到包含乘员监视装置33的监视结果在内的充分的信息作为碰撞时的信息的情况下,可以应对多种多样的碰撞形态,并执行与碰撞时的乘员的乘车状态对应的最佳的乘员保护。乘员保护ecu11在得不到充分的信息作为碰撞时的信息的情况下,可以执行与碰撞形态或乘员的乘车状态无关的通常的乘员保护。

[0095]

图5是包含图4的车内拍摄设备31及乘员监视装置33在内的乘员保护系统60的主要结构图。

[0096]

图5的乘员保护系统60具有:具有车内拍摄设备31的乘员监视装置33、乘员保护ecu11。

[0097]

车内拍摄设备31具有:拍摄元件61、发光元件62、及将它们连接在一起的车内拍摄ecu32。

[0098]

拍摄元件61及发光元件62例如可以朝向后设置在车室3的前部中央。拍摄元件61及发光元件62例如可以朝向后设置在仪表板的中央。拍摄元件61及发光元件62可以设置为在不使用的情况下,能够从车身2卸下。而且,拍摄元件61具有基本上在车室3内可拍摄沿车宽方向并排的一对座椅4及就座于这一对座椅的多个乘员的视场角(画角)。由此,拍摄元件61能够拍摄乘坐于汽车1的多个乘员。

[0099]

这里,将整体地拍摄多个乘员的身体的视场角的范围称为通常拍摄范围a1。通常拍摄范围a1也可以是整体地拍摄例如驾驶员等的乘员的身体的视场角范围。另外,将拍摄通常拍摄范围a1的一部分即驾驶员的上身及头部的视场角的范围称为上身拍摄范围a2。另外,将拍摄上身拍摄范围a2的一部分即驾驶员的头部的视场角的范围称为头部拍摄范围a3。另外,发光元件62对被拍摄的多个乘员的头部照射例如红外线光。

[0100]

车内拍摄ecu32在内部具有设定存储器63。在设定存储器63内记录有程序及设定数据。在设定存储器63内可以记录例如拍摄图像的输出帧率的设定数据、拍摄范围的设定数据。设定数据可以基于乘员监视ecu34的指示而变更。

[0101]

车内拍摄ecu32读入并执行设定存储器63的程序。由此,在车内拍摄ecu32中可实现例如投光控制部65、拍摄控制部66、切取部67、评价部68、修正部69、输出部70作为车内拍摄控制部的功能。

[0102]

投光控制部65控制发光元件62的投光。投光控制部65例如在预测到了碰撞的情况下,可以使发光元件62以最大光量投光,直到判断出避免碰撞为止。

[0103]

拍摄控制部66基于设定存储器63的设定,控制拍摄元件61的拍摄。拍摄控制部66使拍摄元件61按照所设定的拍摄帧率进行拍摄。

[0104]

切取部67基于设定存储器63的设定,从拍摄元件61的拍摄图像中切取指定范围的图像。由此,生成拍摄范围的拍摄图像。在通常拍摄范围a1的拍摄图像的情况下,切取部67可以将拍摄元件61的拍摄图像原封不动地设为拍摄范围的拍摄图像。

[0105]

评价部68对由切取部67生成的拍摄图像,评价例如曝光之类的画质。评价部68运算拍摄图像整体的像素值的平均,生成其平均值作为评价值。

[0106]

修正部69基于评价部68的评价值,修正由切取部67生成的拍摄范围的拍摄图像的画质。例如,修正部69基于由评价部68评价出的图像整体曝光的评价值,修正拍摄图像整体的像素值,以使图像整体的平均曝光成为规定的亮度。由此,拍摄范围的拍摄图像成为容易用于其后处理的曝光(亮度)的图像。

[0107]

输出部70通过车载网络44,将由修正部69修正后的拍摄范围的拍摄图像输出到乘员监视ecu34等。

[0108]

由此,按照由乘员监视ecu34指定的每个输出帧率,从车内拍摄设备31的输出部70输出由乘员监视ecu34指定的拍摄范围的拍摄图像。

[0109]

图6是由图4的乘员监视ecu34执行的拍摄控制的流程图。

[0110]

乘员监视ecu34例如在汽车1的车载网络44启动时,开始进行图6的处理。乘员监视ecu34例如持续执行图6的处理,直到汽车1的车载网络44停止为止。

[0111]

在步骤st1中,乘员监视ecu34将作为第一拍摄范围的通常拍摄范围a1内的拍摄设定于设定存储器63。由此,车内拍摄设备31输出整体地拍摄乘坐于汽车1的多个乘员的身体所得的通常拍摄范围a1的拍摄图像。车内拍摄设备31以通常的帧率,输出由拍摄元件61的所有像素实现的通常拍摄范围a1的拍摄图像。

[0112]

在步骤st2中,乘员监视ecu34取得从车内拍摄设备31输出的通常拍摄范围a1的拍摄图像。另外,乘员监视ecu34从通常拍摄范围a1的拍摄图像中,抽取乘坐于汽车1的驾驶员的上身及头部。然后,乘员监视ecu34基于通常拍摄范围a1内的上身及头部的拍摄位置及范围等,判定车室3内的驾驶员的上身的位置及朝向、以及头部的位置及朝向。

[0113]

在步骤st3中,乘员监视ecu34通过车载网络44,将在步骤st2中判定出的驾驶员的上身及头部的拍摄范围的信息和仅头部的拍摄范围的信息输出到车内拍摄设备31。车内拍摄ecu32将已取得的驾驶员的上身及头部的拍摄范围作为上身拍摄范围a2而记录于设定存储器63。车内拍摄ecu32将已取得的仅驾驶员的头部的拍摄范围作为头部拍摄范围a3而记录于设定存储器63。车内拍摄ecu32在其后的处理中,使用更新后的上身拍摄范围a2及头部拍摄范围a3。

[0114]

在步骤st4中,乘员监视ecu34判断是否预测到了汽车1的碰撞。碰撞预测ecu42基于车外拍摄设备47的图像或通信设备38的信息等,判断本车的碰撞可能性。在有本车的碰

撞可能性的情况下,碰撞预测ecu42将碰撞预测信息输出到车载网络44。乘员监视ecu34在有碰撞预测信息的情况下,判断为预测到了汽车1的碰撞,使处理进入步骤st5。在这以外的情况下,乘员监视ecu34判断为未预测到汽车1的碰撞,使处理返回到步骤st2。乘员监视ecu34直到预测到碰撞为止,都重复进行步骤st2至步骤st4的处理,持续基于最新的通常拍摄图像来更新记录于设定存储器63的上身拍摄范围a2及头部拍摄范围a3。

[0115]

在步骤st5中,乘员监视ecu34基于最新的通常拍摄图像,判断能否高精度地判定驾驶员的上身及头部的位置及朝向。

[0116]

驾驶员的拍摄环境时刻都随着汽车1的行驶环境等而发生较大变化。例如,如图5所示,在夕阳或朝阳映入通常拍摄图像的情况下,车外变亮,通过曝光等画质调节,车内相对变暗。在这种情况下,驾驶员的上身及头部也拍摄得相对较暗。除此以外,例如,在日光或其他汽车1的远光等强光照射到驾驶员的头部或上身的情况下,有时即使进行曝光等画质调节,在图像中也不会清楚地映射出被照射部分。在这种驾驶员的上身及头部不能在图像上清楚地映射出的情况下,难以高精度地判定驾驶员的上身及头部的位置及朝向。

[0117]

因此,乘员监视ecu34例如对最新的通常拍摄图像进行边缘处理,尝试能否在边缘处理后的通常拍摄范围a1的图像中抽取面部的轮廓、眼、鼻、口、肩之类的规定特征。在图像中清楚地映射出头部的情况下,能够在边缘处理后的图像中抽取面部的规定特征。在这种情况下,乘员监视ecu34判断为能够高精度地判定驾驶员的上身及头部的位置及朝向,使处理进入步骤st18。在不能高精度地判定的情况下,乘员监视ecu34使处理进入步骤st6。

[0118]

在步骤st6中,乘员监视ecu34将作为第二拍摄范围的上身拍摄范围a2的拍摄设定于设定存储器63。由此,车内拍摄设备31开始输出整体地拍摄乘坐于汽车1的驾驶员的包含乘员头部在内的上身所得的上身拍摄范围a2的拍摄图像。车内拍摄设备31开始以通常的帧率输出由拍摄元件61的一部分像素实现的上身拍摄范围a2的拍摄图像。

[0119]

这样,乘员监视ecu34在检测到汽车1的碰撞之前预测到汽车1的碰撞时,在不能基于通常拍摄图像而高精度地判定乘员的乘车状态的情况下,将从车内拍摄设备31输出的拍摄图像的拍摄范围(视场角)切换为较窄。

[0120]

在步骤st7中,乘员监视ecu34取得从车内拍摄设备31输出的上身拍摄范围a2的拍摄图像。另外,乘员监视ecu34从上身拍摄图像中,抽取乘坐于汽车1的驾驶员的上身及头部。然后,乘员监视ecu34基于上身拍摄范围a2内的上身及头部的拍摄位置及范围等,判定车室3内的驾驶员的上身的位置及朝向、以及头部的位置及朝向。

[0121]

在步骤st8中,乘员监视ecu34基于最新的上身拍摄图像,判断能否高精度地判定驾驶员的上身及头部的位置及朝向。与步骤st5的情况相比,拍摄范围较窄。由此,在图像中难以映射出太阳。另外,即使向驾驶员的上身及头部照射了强光,包含该驾驶员的上身及头部的图像整体的亮度之差等的画质之差也会变小。与步骤st5的情况相比,在图像中容易清楚地映射出驾驶员的上身及头部。

[0122]

乘员监视ecu34例如对最新的上身拍摄图像进行边缘处理,尝试能否在边缘处理后的上身拍摄范围a2的图像中抽取面部的轮廓、眼、鼻、口、肩之类的规定特征。在图像中清楚地映射出头部的情况下,能够在边缘处理后的图像中抽取面部的规定特征。在这种情况下,乘员监视ecu34判断为能够通过上身拍摄图像而高精度地判定驾驶员的上身及头部的位置及朝向,使处理进入步骤st18。在不能高精度地判定的情况下,乘员监视ecu34使处理

进入步骤st9。

[0123]

在步骤st9中,乘员监视ecu34将作为第三拍摄范围的头部拍摄范围a3内的拍摄设定于设定存储器63。由此,车内拍摄设备31开始输出整体地拍摄乘坐于汽车1的驾驶员之乘员的头部所得的头部拍摄范围a3的拍摄图像。车内拍摄设备31以通常的帧率,开始输出由拍摄元件61的一部分像素实现的头部拍摄范围a3的拍摄图像。

[0124]

这样,乘员监视ecu34在检测到汽车1的碰撞之前预测到汽车1的碰撞时,在不能基于通常拍摄图像及上身拍摄图像而高精度地判定乘员的乘车状态的情况下,将从车内拍摄设备31输出的拍摄图像的拍摄范围(视场角)进一步切换为较窄。

[0125]

在步骤st10中,乘员监视ecu34取得从车内拍摄设备31输出的头部拍摄范围a3的拍摄图像。另外,乘员监视ecu34从头部拍摄图像中,抽取乘坐于汽车1的驾驶员的头部。然后,乘员监视ecu34基于头部拍摄范围a3内的头部的拍摄位置及范围等,判定车室3内的驾驶员的头部的位置及朝向。

[0126]

在步骤st11中,乘员监视ecu34基于最新的头部拍摄图像,判断能否高精度地判定驾驶员的头部的位置及朝向。与步骤st5或步骤st8的情况相比,拍摄范围较窄。由此,太阳难以映入图像。另外,即使向驾驶员的上身及头部照射强光,包含该驾驶员的上身及头部在内的图像整体的亮度之差等的画质之差也会变小。与步骤st5的情况或步骤st8的情况相比,在图像中容易清楚地映射出驾驶员的头部。

[0127]

乘员监视ecu34例如对最新的头部拍摄图像进行边缘处理,尝试能否在边缘处理后的头部拍摄范围a3的图像中抽取面部的轮廓、眼、鼻、口之类的规定特征。在图像中清楚地映射出头部的情况下,能够在边缘处理后的图像中抽取面部的规定特征。在这种情况下,乘员监视ecu34判断为能够通过头部拍摄图像等高精度地判定驾驶员的上身及头部的位置及朝向,使处理进入步骤st18。在不能高精度地判定的情况下,乘员监视ecu34使处理进入步骤st12。

[0128]

在步骤st12中,乘员监视ecu34将每个微小范围a4的拍摄设定于设定存储器63,该微小范围a4是将头部拍摄范围a3划分成多个而进行拍摄的范围。具体地说,例如,乘员监视ecu34将一次拍摄范围设定为可在车内拍摄设备31中设定的最小范围。另外,乘员监视ecu34设定为将从车内拍摄设备31输出拍摄图像的输出帧率提高到可在车内拍摄设备31中设定的最大帧率。由此,车内拍摄设备31开始输出针对每个微小范围a4来拍摄头部拍摄范围a3的微小图像。车内拍摄设备31开始以最大的帧率而高速地输出针对每个微小范围a4来拍摄头部拍摄范围a3所得的拍摄图像。

[0129]

在步骤st13中,乘员监视ecu34从车内拍摄设备31中取得针对每个微小范围a4来拍摄头部拍摄范围a3所得的微小图像。

[0130]

在步骤st14中,乘员监视ecu34判断头部拍摄范围a3内的一组多个微小图像的取得是否已完成。在一组微小图像的取得未完成的情况下,乘员监视ecu34使处理返回到步骤st13。乘员监视ecu34重复进行步骤st13及步骤st14的处理,直到头部拍摄范围a3内的一组多个微小图像的取得结束为止。当头部拍摄范围a3内的一组多个微小图像的取得结束时,乘员监视ecu34使处理进入步骤st15。

[0131]

在步骤st15中,乘员监视ecu34对已取得的头部拍摄范围a3内的一组多个微小图像进行合成,生成头部拍摄范围a3的图像。乘员监视ecu34例如可以针对每个微小图像来执

行边缘处理,然后对边缘处理后的多个微小图像进行合成,生成头部拍摄范围a3的边缘图像。通过针对每个微小图像进行边缘处理,各图像所含的头部特征容易留在边缘图像中。另外,通过对边缘图像进行合成,可抑制原始图像的画质的差异,容易在边缘图像彼此的连接部分中连续地得到头部特征。容易在合成图像中整体地得到头部特征。

[0132]

在步骤st16中,乘员监视ecu34基于合成后的头部拍摄图像,判断能否高精度地判定驾驶员的头部的位置及朝向。在针对每个微小图像进行边缘处理而合成的图像中,与对头部拍摄图像的整体进行边缘处理所得到的图像相比,与面部特征对应的边缘成分容易留在图像中。在图像中容易比步骤st10的情况更清楚地映射出驾驶员的头部特征。

[0133]

乘员监视ecu34例如尝试能否在边缘处理完毕的合成图像中抽取面部的轮廓、眼、鼻、口之类的规定特征。在图像中清楚地映射出头部的情况下,能够在边缘处理后的图像中抽取面部的规定特征。在这种情况下,乘员监视ecu34判断为能够通过头部拍摄图像等而高精度地判定驾驶员的上身及头部的位置及朝向,使处理进入步骤st17。在不能高精度地判定的情况下,乘员监视ecu34使处理进入步骤st19。

[0134]

在步骤st17中,乘员监视ecu34执行上身拍摄范围a2内的分割拍摄。乘员监视ecu34将上身拍摄范围a2的拍摄设定于设定存储器63,从车内拍摄设备31中取得将上身拍摄图像分割为多个而进行拍摄的多个微小图像。乘员监视ecu34对多个微小图像进行了边缘处理之后再进行合成,取得驾驶员的上身拍摄图像。乘员监视ecu34基于合成的驾驶员的上身拍摄图像,并基于驾驶员的肩之类的特征,判定驾驶员的上身的位置及朝向。

[0135]

在步骤st18中,乘员监视ecu34将高精度判定出的驾驶员的上身的位置及朝向以及头部的位置及朝向之类的、驾驶员的乘车状态信息输出到车载网络44。乘员保护ecu11取得该高精度地判定出的驾驶员的乘车状态信息,记录于保护存储器12作为乘员信息的设定数据。其后,当检测到了碰撞时,乘员保护ecu11基于保护存储器12的设定数据,执行对乘员的保护控制。乘员保护ecu11基于高精度地判定出的驾驶员的乘车状态的乘员信息,能够在多种多样的碰撞形态中执行与碰撞时的乘员的乘车状态对应的最佳乘员保护。

[0136]

在步骤st19中,乘员监视ecu34判断是否还剩余着直到碰撞为止的剩余时间。乘员监视ecu34例如在从由系统计时器35测量的当前时刻到预想到碰撞的定时为止的剩余时间为例如从步骤st13到步骤st17的处理所需要的时间以上的情况下,判断为还剩余着直到碰撞为止的剩余时间,使处理返回到步骤st13。在这种情况下,乘员监视ecu34重复执行从步骤st13到步骤st17的处理,且尝试高精度判定驾驶员的头部的位置及朝向,直到碰撞前的剩余时间不足为止。乘员监视ecu34在直到乘员保护ecu11基于汽车1的碰撞检测执行乘员的保护控制为止还有剩余时间的情况下,通过车内拍摄设备31,重复进行将头部拍摄范围a3分割为多个而进行拍摄的处理。在剩余时间不足的情况下,乘员监视ecu34使处理进入步骤st20。

[0137]

在步骤st20中,乘员监视ecu34因为不能进行驾驶员的乘车状态的高精度判定,所以将驾驶员的最小限度的乘车状态信息输出到车载网络44。乘员保护ecu11取得该简易的驾驶员的乘车状态信息,记录于保护存储器12作为乘员信息的设定数据。其后,当检测到了碰撞时,乘员保护ecu11基于保护存储器12的设定数据,执行对乘员的通常的保护控制。乘员保护ecu11例如可以不使用驾驶员的乘车状态而执行仅与碰撞形态对应的通用的乘员保护。

[0138]

图7(a)-(c)是太阳映入车内拍摄设备31的通常拍摄图像的情况的说明图。

[0139]

图7(a)是通常拍摄图像。图7(b)是驾驶员的上身拍摄图像。图7(c)是驾驶员的头部拍摄图像。

[0140]

在图7(a)-(c)的拍摄环境中,太阳映入了通常拍摄图像中。

[0141]

在这种情况下,车内拍摄设备31针对图7(a)的通常拍摄范围a1的拍摄图像,以降低图像整体的亮度的方式修正画质,以使其得到有太阳的车外的亮度。其结果是,存在于车内的驾驶员等乘员的上身及头部映入得较暗,以至于不能判定其位置或朝向。乘员监视ecu34在步骤st5的判断中,判断为不能对通常拍摄图像进行高精度的判定。

[0142]

另外,在图7(b)的通常拍摄范围a2的拍摄图像中未映射出太阳。在这种情况下,车内拍摄设备31修正图像整体的亮度之类的画质,以使其得到逆光和车内的亮度。其结果是,存在于车内的驾驶员等乘员的上身及头部比图7(a)的通常拍摄图像映射得亮。乘员监视ecu34在步骤st8的判断中,有时也判断为不能对上身拍摄图像进行高精度的判定。实际上,在图7(b)的上身拍摄图像中,与图7(a)的通常拍摄图像不同,驾驶员的头部的鼻或口之类的特征会映入图像。

[0143]

但是,在对上身拍摄图像也不能进行高精度的判定的情况下,车内拍摄设备31拍摄图7(c)的头部拍摄图像。在这种情况下,基本上只能映射出乘员的头部等的车内。因此,车内拍摄设备31以提高图像整体的亮度的方式修正画质,以使其消除逆光的影响。其结果是,在图7(c)的头部拍摄图像中,驾驶员的头部的眼、鼻及口之类的特征比图7(b)的上身拍摄图像更清楚地映入图像。在这种情况下,乘员监视ecu34在步骤st11的判断中,能够判断为可对头部拍摄图像进行高精度的判定。

[0144]

图8(a)-(b)是在驾驶员的头部拍摄图像中欠缺地映射出了头部的一部分的情况的说明图。

[0145]

图8(a)是步骤st9的驾驶员的头部拍摄图像。

[0146]

图8(b)是通过步骤st12而分割拍摄的多个微小图像的合成图像。

[0147]

在图8(a)-(b)的拍摄环境中,在驾驶员的头部的右半部分照射有太阳等的强光。

[0148]

在这种情况下,车内拍摄设备31在图8(a)的头部拍摄图像中以降低图像整体的亮度的方式修正画质,以使其得到头部的右半部分的亮度。其结果是,存在于车内的驾驶员等乘员的头部的其余部分映射得较暗,以至于不能判定其位置或朝向。乘员监视ecu34在步骤st11的判断中,判断为不能对头部拍摄图像进行高精度的判定。

[0149]

然后,车内拍摄设备31基于乘员监视ecu34的指示,如图8(b)那样将头部拍摄图像分割为多个微小范围a4分别进行拍摄。在图8(b)的例子中,车内拍摄设备31首先拍摄头部拍摄图像的中央的微小范围a4,其后按照右旋的顺序且按照从内向外的顺序拍摄周围的多个微小范围a4。乘员监视ecu34当取得左上方的最后的微小范围a4的图像时,就执行图像合成。

[0150]

由此,在图8(b)的合成图像中,驾驶员的头部的眼、鼻及口之类的特征比图8(a)的头部拍摄图像更清楚地映入图像。在这种情况下,乘员监视ecu34在步骤st16的判断中,能够判断为可对合成图像进行高精度的判定。

[0151]

如这些图7(a)-(c)及图8(a)-(b)所示,乘员监视ecu34即使在通常拍摄图像中因例如拍摄范围的一部分较亮而使驾驶员的上身或头部等变白或变黑(黒抜

けする

)那样的

情况下,也能够通过缩小拍摄范围而取得拍摄图像,并基于该狭窄范围的拍摄图像进行高精度的乘员的乘车状态的判定。另外,乘员保护ecu11能够基于对乘员的乘车状态的高精度的判定结果,执行与乘员的乘车状态对应的最佳的乘员保护控制。

[0152]

如上所述,在本实施方式中,乘员监视装置33在不能基于从车内拍摄设备31输出的拍摄图像来判定乘员的上身或头部的在汽车1内的乘车状态例如位置、朝向、姿势等的情况下,将从车内拍摄设备31输出的拍摄图像的拍摄范围(视场角)切换为比不能判定的拍摄图像更窄。通过拍摄范围被切换得更窄,难以在拍摄图像中出现乘员以外的物体,可以期待车内拍摄设备31能够适当地拍摄乘坐于汽车1的乘员。其结果是,乘员监视装置33能够基于切换后的拍摄图像,判定乘员的上身或头部在汽车1内的乘车状态。另外,乘员保护装置10能够基于更准确地判定出了汽车1内的乘车状态的乘员监视装置33的监视结果,适当地执行与乘坐于汽车1的乘员对应的保护控制。

[0153]

在汽车1中,拍摄乘员的车内拍摄设备31基本上在车内设置为固定的位置及朝向。因此,例如在拍摄范围内出现了朝阳或夕阳的情况下,图像整体有可能变白。在图像整体变白的情况下,难以基于其拍摄图像,正确地判定乘员的上身或头部在汽车1内的乘车状态。在这种情况下,就会基于不正确的判定执行对乘员的保护控制,不能对乘坐于汽车1的乘员适当地执行保护控制的可能性升高。

[0154]

与此相对,在本实施方式中,在不能基于从车内拍摄设备31输出的拍摄图像来判定乘员的上身或头部在汽车1内的乘车状态的情况下,将从车内拍摄设备31输出的拍摄图像的拍摄范围切换为狭窄。例如,在不能基于从车内拍摄设备31输出的拍摄图像来判定乘员的上身或头部在汽车1内的乘车状态的情况下,将从车内拍摄设备31输出的拍摄图像的拍摄范围切换为比不能判定的拍摄图像更窄。由此,即使拍摄乘员的车内拍摄设备31在车内设置为固定的位置及朝向,乘员监视装置33也能够基于切换后的例如无朝阳或夕阳映入的拍摄图像,正确判定乘员的上身或头部在汽车1内的乘车状态。能够基于正确的判定,执行对乘员的保护控制,能够对乘坐于汽车1的乘员适当地执行保护控制。通过使用本实施方式的乘员监视装置33,乘员保护装置10能够在多种多样的碰撞形态中,根据碰撞时的乘员的乘车状态等,执行适合该乘车状态的乘员保护。

[0155]

特别是,在本实施方式中,车内拍摄设备31自身评价拍摄图像而修正并输出例如曝光之类的画质。当使用这种车内拍摄设备31时,在例如太阳光等强光被乘员的头部或上身反射时,拍摄图像被以整体地抑制拍摄图像的曝光之类的画质的方式进行修正,以使其得到最亮部位的图像。例如,以仅眼镜的玻璃适当曝光的方式使图像整体变暗。这样,当在拍摄图像中高亮度部位以外的部位变暗时,乘员监视装置33难以在拍摄图像中正确地判定乘员的头部或上身的位置或朝向。在本实施方式中,在这种修正在车内拍摄设备31中执行的情况下,将从车内拍摄设备31输出的拍摄图像的拍摄范围切换为狭窄。通过将拍摄图像的拍摄范围切换为狭窄,能够期待在拍摄图像中缩小高亮度部位和其以外的部分的画质之差,例如亮度之差。高亮度部位以外的部分难以变暗。乘员监视装置33能够基于高亮度部位以外的部分的图像,判定乘员的头部或上身的位置或朝向。

[0156]

以上实施方式是本发明的最佳实施方式的例子,但本发明不限定于此,可在不脱离本发明主旨的范围内进行种种变形或变更。

[0157]

例如,在上述实施方式中,在通常拍摄图像中不能高精度地确定乘员的乘车状态

的情况下,乘员监视ecu34按照从通常拍摄范围a1向包含头部在内的上身拍摄范围a2,进而从上身拍摄范围a2向头部拍摄范围a3的顺序以三阶段变窄的方式切换车内拍摄设备31的拍摄范围。

[0158]

除此以外,例如,乘员监视ecu34也可以按照两阶段变窄的方式,还可以按照四阶段以上变窄的方式切换车内拍摄设备31的拍摄范围。

[0159]

例如,乘员监视ecu34也可以从通常拍摄图像向头部拍摄范围a3分两阶段来切换。另外,乘员监视ecu34也可以从通常拍摄图像向上身拍摄范围a2分两阶段来切换。

[0160]

在上述实施方式中,乘员监视ecu34对头部拍摄范围a3进行分割而分割为多个微小范围a4,然后针对每个微小范围a4进行拍摄。

[0161]

除此以外,例如,乘员监视ecu34也可以对上身拍摄范围a2进行分割而分割为多个微小范围a4,然后针对每个微小范围a4进行拍摄。

[0162]

在上述实施方式中,乘员监视ecu34在将头部拍摄范围a3分割为多个微小范围a4并针对每个微小范围a4进行拍摄的情况下,将从车内拍摄设备31输出的输出帧率从通常的帧率提高到最大帧率。

[0163]

除此以外,例如,乘员监视ecu34即使在拍摄上身拍摄范围a2的情况下,或者在拍摄头部拍摄范围a3的情况下,也将从车内拍摄设备31输出的输出帧率提高到最大帧率。另外,乘员监视ecu34当预测到了碰撞时,也可以将输出帧率提高到最大帧率。

[0164]

在上述实施方式中,乘员监视ecu34仅在能够在包含合成图像在内的拍摄图像中进行高精度判定的情况下,输出用于最佳展开的乘员的乘车状态信息。

[0165]

除此以外,例如,乘员监视ecu34即使在不能在包含合成图像在内的拍摄图像中进行高精度判定的情况下,也可以输出最佳推定出的乘员的乘车状态信息,而不是输出用于通常展开的乘员的乘车状态信息。

起点商标作为专业知识产权交易平台,可以帮助大家解决很多问题,如果大家想要了解更多知产交易信息请点击 【在线咨询】或添加微信 【19522093243】 与客服一对一沟通,为大家解决相关问题。

与客服一对一沟通,为大家解决相关问题。

此文章来源于网络,如有侵权,请联系删除

相关标签: 预测控制

热门咨询

热门咨询

tips

商标分类

商标分类  商标转让

商标转让